Por Elena Vargas, Periodista Especializada en Ciencia y Tecnología, para Mundo IA

La revolución silenciosa de la investigación automatizada

En los laboratorios de NVIDIA Research, un equipo liderado por Peter Belcak y Pavlo Molchanov acaba de presentar una innovación que podría transformar radicalmente la manera en que concebimos la investigación digital. Se trata de Universal Deep Research, un sistema que promete democratizar y personalizar completamente el proceso de investigación automatizada, permitiendo a cualquier usuario definir sus propias estrategias de búsqueda y análisis sin necesidad de conocimientos técnicos avanzados.

Para comprender la magnitud de esta propuesta, es necesario situarnos en el contexto actual de las herramientas de investigación profunda. Desde hace algunos años, asistimos al auge de sistemas de inteligencia artificial capaces de realizar investigaciones exhaustivas de manera autónoma. Plataformas como ChatGPT Deep Research de OpenAI, Gemini Deep Research de Google o Perplexity Research han conquistado a millones de usuarios al ofrecer la posibilidad de generar informes detallados y bien documentados en cuestión de minutos, combinando la capacidad de búsqueda web con la síntesis inteligente de información.

Sin embargo, estos sistemas comparten una limitación fundamental: funcionan como cajas negras con estrategias de investigación predeterminadas y rígidas. El usuario introduce una consulta y el sistema ejecuta un proceso fijo de búsqueda, análisis y síntesis, sin posibilidad de personalización o control sobre la metodología empleada. Es como tener un asistente de investigación extremadamente competente pero inflexible, que siempre trabaja de la misma manera independientemente del tipo de proyecto o las necesidades específicas del usuario.

Aquí radica la genialidad de la propuesta de NVIDIA: el sistema invierte completamente este paradigma al convertir al usuario en el arquitecto de su propia estrategia de investigación. En lugar de limitarse a formular preguntas, ahora puede describir en lenguaje natural exactamente cómo desea que se lleve a cabo la investigación, qué fuentes priorizar, qué metodología seguir y qué formato debe tener el resultado final. La plataforma toma estas instrucciones y las convierte automáticamente en código ejecutable, actuando como un traductor entre las intenciones humanas y la implementación técnica.

La innovación técnica detrás de esta herramienta se basa en dos fases claramente diferenciadas. La primera consiste en el procesamiento de la estrategia definida por el usuario, que el mecanismo traduce a una función ejecutable siguiendo estrictas restricciones de control y herramientas disponibles. Esta traducción no es trivial: requiere que el modelo de lenguaje comprenda instrucciones complejas y las transforme en código funcional que respete tanto la intención original como las limitaciones técnicas del sistema.

La segunda fase ejecuta esta estrategia traducida en un entorno aislado y controlado. Aquí es donde se aprecia una de las decisiones arquitectónicas más inteligentes del framework: la separación radical entre la lógica de control y el razonamiento del modelo de lenguaje. Mientras que los sistemas tradicionales mantienen toda la información en el contexto del modelo (lo que consume recursos computacionales exponencialmente), esta plataforma almacena los datos en variables de código persistentes, permitiendo que el modelo opere con ventanas de contexto pequeñas y eficientes.

Esta arquitectura híbrida genera beneficios inmediatos en términos de eficiencia computacional. El procesamiento principal se ejecuta en CPU, reservando las llamadas al modelo de lenguaje únicamente para tareas específicas como resumen, clasificación o extracción de información. Esto no solo reduce drásticamente los costos operativos, sino que también mejora la velocidad y confiabilidad del sistema completo.

Arquitectura revolucionaria para la personalización total

La verdadera revolución del framework reside en su capacidad para adaptarse a cualquier modelo de lenguaje y cualquier estrategia de investigación. Esta versatilidad, conocida técnicamente como «agnóstico al modelo», significa que la herramienta puede funcionar igual de bien con GPT-4, Claude, Llama, o cualquier otro modelo presente o futuro, sin requerir modificaciones en su arquitectura base.

Esta flexibilidad contrasta marcadamente con las limitaciones de los sistemas actuales. ChatGPT Deep Research está intrínsecamente vinculado a los modelos de OpenAI, Gemini Deep Research solo puede utilizar los modelos de Google, y así sucesivamente. La plataforma rompe estas barreras al crear una capa de abstracción que separa la estrategia de investigación del modelo específico utilizado para ejecutarla.

Para demostrar esta versatilidad, los investigadores han desarrollado tres estrategias de ejemplo que ilustran diferentes enfoques metodológicos. La estrategia «mínima» implementa un proceso básico de búsqueda y síntesis, ideal para consultas directas que requieren respuestas rápidas y concisas. La estrategia «expansiva» divide el tema en subtemas relacionados para obtener una cobertura más amplia, mientras que la estrategia «intensiva» emplea múltiples iteraciones de búsqueda, refinando progresivamente los términos de búsqueda basándose en los resultados obtenidos.

Estas metodologías pueden modificarse, combinarse o reemplazarse completamente según las necesidades específicas de cada proyecto. Un investigador académico podría diseñar una estrategia que priorice fuentes científicas peer-reviewed y implemente verificación cruzada de datos. Un analista financiero podría crear una metodología que se centre en informes regulatorios y bases de datos económicas. Un periodista podría desarrollar un enfoque que balance múltiples perspectivas y verifique la credibilidad de las fuentes.

La interfaz de usuario desarrollada para el sistema refleja esta filosofía de control granular. Incluye no solo la tradicional barra de búsqueda para introducir consultas, sino también herramientas específicas para seleccionar, editar y crear estrategias de investigación. Los usuarios pueden visualizar en tiempo real el progreso de su investigación a través de notificaciones estructuradas que muestran exactamente qué está haciendo el mecanismo en cada momento, qué fuentes está consultando y cómo está procesando la información.

Esta transparencia operacional representa otro avance significativo respecto a las herramientas existentes. Mientras que las plataformas actuales muestran progreso de manera genérica («buscando información», «analizando resultados»), el framework proporciona actualizaciones específicas definidas por la estrategia del usuario. Si la metodología incluye verificación de fuentes, la herramienta informará específicamente sobre ese proceso. Si requiere análisis comparativo, mostrará el progreso de esa tarea particular.

Implicaciones transformadoras para diferentes sectores

Las aplicaciones potenciales de esta tecnología trascienden los límites de la investigación académica tradicional para abarcar prácticamente cualquier sector que requiera análisis sistemático de información. En el ámbito empresarial, las organizaciones pueden desarrollar estrategias de investigación específicamente diseñadas para sus bases de datos internas, combinando información pública con repositorios corporativos bajo metodologías adaptadas a sus procesos de toma de decisiones.

El sector financiero podría beneficiarse enormemente de estrategias que integren análisis fundamental y técnico, correlacionando datos de mercado con informes regulatorios y noticias sectoriales. Los analistas podrían crear metodologías que automáticamente actualicen sus modelos de valoración cuando se publiquen nuevos datos económicos, o que generen alertas cuando ciertos indicadores superen umbrales predefinidos.

En el ámbito legal, los bufetes de abogados podrían desarrollar estrategias de investigación jurisprudencial que rastreen precedentes relevantes, analicen tendencias en decisiones judiciales y generen resúmenes de casos similares. Estas metodologías podrían adaptarse a diferentes jurisdicciones, áreas del derecho o tipos de procedimientos, proporcionando a los letrados herramientas de investigación tan especializadas como su práctica profesional.

El sector sanitario presenta oportunidades igualmente prometedoras. Los profesionales médicos podrían crear estrategias que combinen literatura científica reciente con bases de datos de ensayos clínicos, guidelines de organizaciones profesionales y reportes de efectos adversos. Estas metodologías podrían personalizarse según especialidades médicas, poblaciones de pacientes o condiciones específicas.

Los medios de comunicación encontrarían en la plataforma una herramienta particularmente valiosa para el periodismo de investigación. Los reporteros podrían desarrollar estrategias que automáticamente verifiquen información a través de múltiples fuentes, rastreen la evolución temporal de una historia o identifiquen conexiones entre diferentes eventos o actores. Estas metodologías podrían incorporar verificación de hechos, análisis de sesgos en las fuentes y seguimiento de la credibilidad de la información.

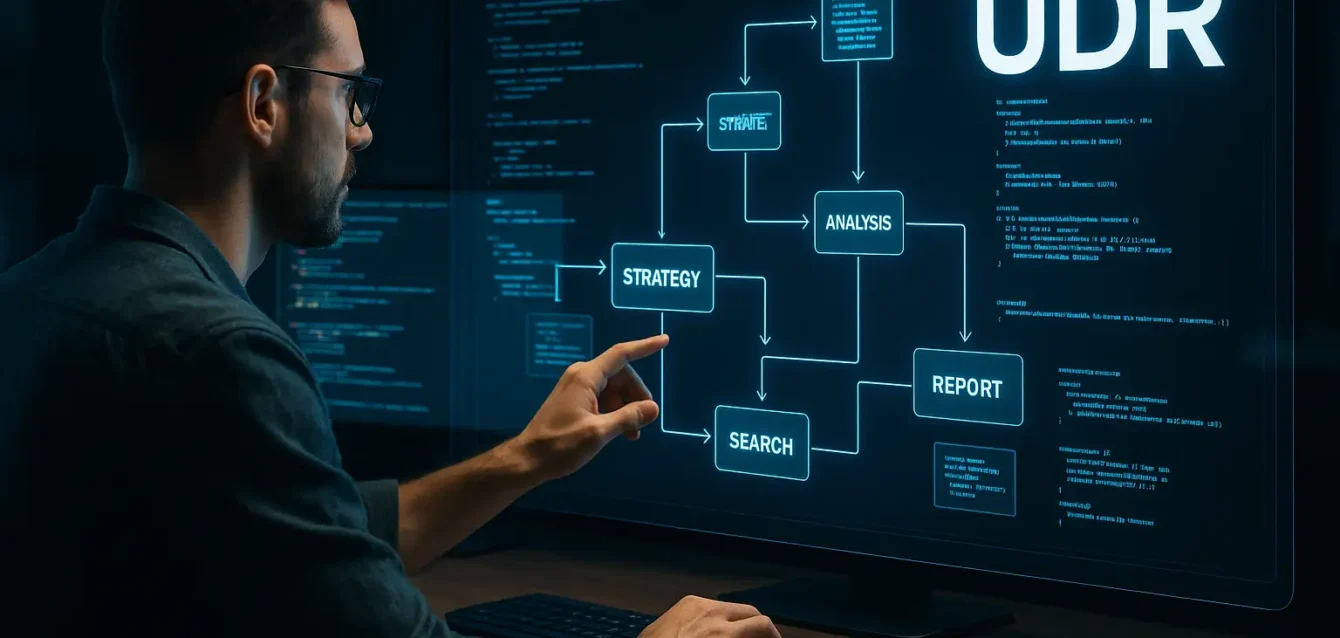

Una ilustración de la configuración de UDR. El agente de investigación profunda toma tanto la estrategia de investigación como el prompt de investigación como entradas, compila la estrategia desde lenguaje natural en un fragmento de código de orquestación de investigación accionable y luego ejecuta la estrategia, entregando el informe final al usuario.

Desafíos técnicos y limitaciones inherentes

A pesar de sus avances revolucionarios, el sistema enfrenta desafíos significativos que los propios investigadores reconocen con transparencia. El más crítico radica en la dependencia de la calidad del código generado por el modelo de lenguaje subyacente. Aunque la herramienta mitiga inconsistencias mediante una estructura rigurosa de comentarios y código, estrategias ambiguas o insuficientemente especificadas pueden resultar en comportamientos impredecibles o errores lógicos.

Esta limitación es particularmente relevante porque el framework asume que las estrategias definidas por los usuarios son lógicamente coherentes y técnicamente viables. La plataforma no valida la efectividad metodológica de las estrategias propuestas más allá de verificaciones básicas de sintaxis y ejecución. Una estrategia mal diseñada puede generar informes de baja calidad, incompletos o simplemente fallar en su ejecución.

La ausencia de interactividad en tiempo real durante la ejecución representa otra limitación importante. Una vez iniciada la investigación, los usuarios no pueden intervenir dinámicamente para redirigir el proceso basándose en resultados intermedios. Toda la lógica de decisión debe estar codificada previamente en la estrategia, lo que limita la adaptabilidad en investigaciones exploratorias o cuando surgen hallazgos inesperados que podrían requerir cambios metodológicos.

La seguridad computacional plantea desafíos adicionales. Dado que el mecanismo genera y ejecuta código definido por usuarios, existe riesgo potencial de ataques de inyección de prompts o exploits basados en código malicioso. Aunque los investigadores proponen la ejecución en entornos aislados como medida de seguridad, esta protección debe implementarse rigurosamente en cualquier despliegue productivo del sistema.

Eficiencia computacional e innovaciones arquitectónicas

Una de las contribuciones más significativas de la herramienta radica en su innovador enfoque hacia la eficiencia computacional. Al separar la lógica de orquestación del razonamiento del modelo de lenguaje, el framework logra una optimización dual que reduce tanto el consumo de recursos como los tiempos de ejecución.

La orquestación del proceso de investigación se ejecuta completamente en CPU mediante código generado, evitando los costos computacionales órdenes de magnitud superiores de la inferencia continua de modelos de lenguaje. Las llamadas al modelo se reservan únicamente para tareas específicas que requieren comprensión semántica, como resumir contenido, clasificar información o extraer datos relevantes de textos complejos.

Esta arquitectura híbrida contrasta favorablemente con sistemas que mantienen todo el contexto de investigación en la ventana del modelo de lenguaje. Mientras estos sistemas enfrentan limitaciones exponenciales de memoria y costos crecientes conforme aumenta la complejidad de la investigación, la plataforma puede mantener contextos arbitrariamente grandes en variables de código sin impacto significativo en el rendimiento.

Los investigadores reportan que la tecnología puede operar efectivamente con ventanas de contexto de solo 8,000 tokens, independientemente de la complejidad o duración del proceso de investigación. Esta eficiencia no solo reduce costos operativos sino que hace viable el uso del sistema para investigaciones extensas que serían económicamente prohibitivas con tecnologías tradicionales.

Perspectivas futuras y recomendaciones estratégicas

Los investigadores de NVIDIA ofrecen recomendaciones específicas para el desarrollo futuro de herramientas similares. Reconocen que, aunque la personalización total representa un avance conceptual significativo, puede resultar intimidante para usuarios finales que prefieren soluciones más inmediatas y accesibles.

La primera recomendación sugiere equipar plataformas similares con bibliotecas comprehensivas de estrategias de investigación predesarrolladas que los usuarios puedan modificar y personalizar gradualmente. Este enfoque reduciría la barrera de entrada mientras preserva la flexibilidad fundamental del framework. Los usuarios podrían comenzar con metodologías probadas y evolucionarlas según sus necesidades específicas.

La segunda recomendación aborda una frontera más ambiciosa: el control directo sobre el «razonamiento libre» de los modelos de lenguaje. Los investigadores sugieren explorar mecanismos que permitan a los usuarios influir no solo en las acciones del sistema sino también en sus procesos internos de pensamiento y análisis.

La tercera recomendación apunta hacia la automatización masiva de workflows complejos. Los investigadores vislumbran la posibilidad de convertir grandes conjuntos de consultas de usuarios en agentes determinísticamente controlados que ejecuten secuencias complejas de acciones de manera autónoma.

Reflexiones sobre el futuro de la investigación automatizada

El desarrollo de esta tecnología señala un momento de inflexión en la evolución de las herramientas de investigación asistida por inteligencia artificial. Más allá de sus innovaciones técnicas específicas, la plataforma representa un cambio filosófico fundamental en la relación entre humanos y sistemas automatizados de análisis de información.

Durante décadas, la automatización ha seguido un patrón predecible: identificar procesos humanos repetitivos, codificarlos en algoritmos y ejecutarlos de manera más rápida y consistente. El framework invierte esta lógica al permitir que los humanos definan la automatización en sus propios términos, usando lenguaje natural en lugar de programación técnica.

Esta inversión tiene implicaciones profundas para la democratización del análisis de datos y la investigación sistemática. Tradicionalmente, la creación de sistemas de investigación automatizada requería equipos de programadores, científicos de datos y especialistas en dominios específicos. La herramienta reduce estas barreras al permitir que expertos en cualquier campo diseñen sus propias metodologías automatizadas sin intermediarios técnicos.

La capacidad de combinar cualquier modelo de lenguaje con cualquier estrategia de investigación también representa un avance hacia la verdadera interoperabilidad en el ecosistema de inteligencia artificial. En lugar de estar limitados por las capacidades o restricciones de un proveedor específico, los usuarios pueden seleccionar los modelos más apropiados para sus necesidades y cambiarlos dinámicamente según evolucionen las tecnologías disponibles.

Sin embargo, esta flexibilidad también plantea nuevas responsabilidades y desafíos éticos. Cuando los usuarios pueden definir completamente sus metodologías de investigación, la calidad y objetividad de los resultados depende enteramente de la sofisticación y honestidad de las estrategias diseñadas. Un mecanismo mal intencionado podría crear metodologías sesgadas que confirmen prejuicios preexistentes o ignoren evidencia contradictoria.

La transparencia operacional de la plataforma, aunque valiosa para la comprensión y verificación de procesos, también requiere que los usuarios desarrollen nuevas competencias para evaluar la calidad metodológica de sus propias estrategias de investigación. Esta necesidad de «literacy metodológica» representa tanto una oportunidad educativa como un potencial obstáculo para la adopción masiva.

El impacto social más amplio de tecnologías como esta podría ser la fragmentación de metodologías de investigación. Mientras que los sistemas actuales imponen una cierta estandarización implícita en sus procesos, la herramienta permite que cada usuario o organización desarrolle enfoques completamente personalizados. Esto podría enriquecer la diversidad metodológica pero también dificultar la comparación y validación entre diferentes estudios o análisis.

Hacia una nueva era de investigación personalizada

Universal Deep Research representa más que una innovación tecnológica incremental; constituye una propuesta paradigmática que reimagina fundamentalmente la relación entre investigadores humanos y herramientas automatizadas de análisis de información. Al convertir a los usuarios en arquitectos de sus propias metodologías de investigación, el sistema democratiza capacidades que históricamente han estado reservadas para equipos técnicos altamente especializados.

La arquitectura híbrida de la plataforma, que separa elegantemente la orquestación ejecutada en CPU del razonamiento semántico de los modelos de lenguaje, establece un nuevo estándar de eficiencia computacional para sistemas agenticos complejos. Esta innovación no solo reduce costos operativos sino que hace económicamente viable la investigación automatizada a escalas previamente prohibitivas.

La capacidad de operar de manera agnóstica respecto al modelo subyacente libera a los usuarios de las limitaciones impuestas por proveedores específicos, permitiendo una optimización dinámica entre costo, velocidad y calidad según las necesidades cambiantes de cada proyecto. Esta flexibilidad representa un valor estratégico considerable en un ecosistema de inteligencia artificial caracterizado por la innovación constante y la obsolescencia rápida.

Sin embargo, las limitaciones identificadas por los propios investigadores subrayan la importancia de desarrollar competencias metodológicas entre los usuarios potenciales. La transición hacia sistemas completamente personalizables requiere una nueva forma de literacy digital que combine comprensión técnica básica con rigor metodológico tradicional.

El futuro sugerido por esta tecnología apunta hacia un ecosistema de investigación más diverso, eficiente y accesible, pero también más complejo en términos de responsabilidades individuales y estándares de calidad. La democratización de herramientas poderosas invariablemente genera tanto oportunidades transformadoras como nuevos desafíos éticos y metodológicos.

En última instancia, el framework no solo representa un avance en la automatización de la investigación, sino una invitación a repensar las fronteras entre la creatividad humana y la ejecución automatizada, entre la intuición metodológica y la precisión computacional. Su éxito residirá tanto en sus capacidades técnicas como en la sabiduría con que la comunidad global de usuarios aprenda a aprovechar su potencial transformador.

Referencias

-

Belcak, P., & Molchanov, P. (2025). Universal Deep Research: Bring Your Own Model and Strategy. NVIDIA Research. arXiv:2509.00244v1.

-

Citron, D. (2024). Try deep research and our new experimental model in gemini, your ai assistant. Google Blog (Products: Gemini).

-

Perplexity Team. (2025). Introducing perplexity deep research. Perplexity Blog.

-

OpenAI. (2025). Introducing deep research. OpenAI Blog.

-

Zhou, C. (2025). Understanding grok: A comprehensive guide to grok websearch, grok deepsearch. Profound Blog.