Por Elena Vargas, Periodista de Ciencia y Tecnología, para Mundo IA

la IA que resucitó 1834 en Londres

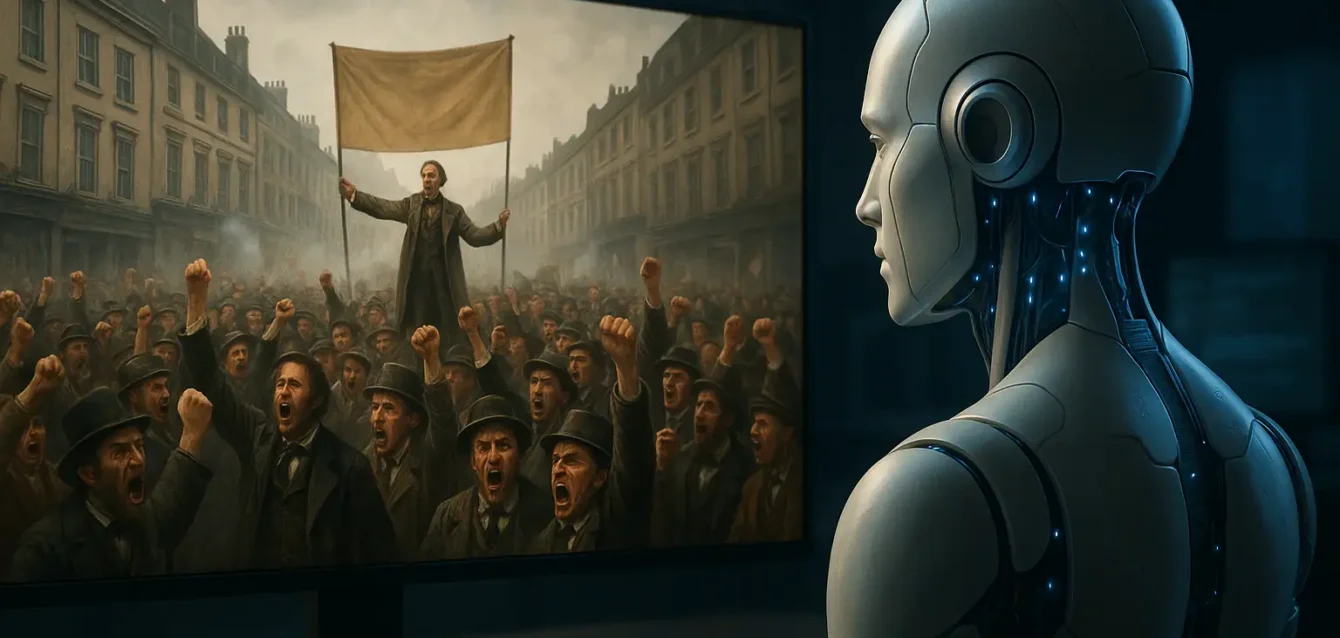

En una época en la que la inteligencia artificial acomoda nuestras agendas, resume informes y hasta sugiere la cena, una historia con sabor victoriano nos recuerda que la tecnología también puede hacer arqueología. Un estudiante curioso, sin supercomputadoras ni presupuestos corporativos, entrenó un modelo de lenguaje limitado a textos de 1800 a 1875 centrados en Londres. Lo bautizó, con tino narrativo, TimeCapsuleLLM. Un día lo probó con una frase inocente, casi litúrgica: “Era el año de nuestro Señor 1834”. La respuesta habló de calles colmadas, peticiones, malestar por una nueva ley de pobres y referencias a figuras del establishment. Al verificar, apareció la sorpresa: 1834 fue, en efecto, un año de efervescencia social, marcado por la Poor Law Amendment Act y por movilizaciones masivas como la marcha por los Tolpuddle Martyrs. La anécdota dejó una intuición potente: los modelos no recuerdan como nosotros, pero pueden recomponer el pasado a partir de regularidades dispersas. Y a veces, en ese tejido, devuelven verdades incómodas.

Una cápsula de tiempo que habla en victorianés

Los modelos de lenguaje aprenden a partir de distribuciones, no de fechas memorizadas. Absorben asociaciones: si “1834” aparece muchas veces cerca de “protesta”, “pobreza”, “workhouse” o “Londres”, un modelo entrenado solo con impresos de la época tenderá a activar ese vecindario semántico. Con un corpus curado, un tokenizador que excluye anacronismos y una arquitectura tipo Transformer, se obtiene una voz que suena a Dickens sin invocar teléfonos inteligentes ni redes sociales. Detrás del encanto hay un mecanismo simple: atención que pondera qué palabras mirar para predecir la siguiente, una invención relativamente reciente que sustituyó a recurrencias y convoluciones por una orquesta de pesos que enfocan relaciones a distintas distancias. El paper fundacional lo explica con claridad y cambió para siempre el procesamiento del lenguaje.

La gracia de TimeCapsuleLLM no es una pose estética. Es una restricción metodológica. En lugar de tragar la web contemporánea con sus sesgos y modas, la máquina se educa en un mundo lexical más estrecho, aunque coherente, donde “pobreza” remite a parroquias, uniones y socorros, donde “reforma” significa a menudo “centralización” y “disciplina”. Si la cápsula está bien cerrada, el modelo rehuye los anacronismos por simple ausencia estadística. Y ahí aparece lo fascinante: de esa carestía controlada emergen asociaciones que resultan verosímiles para un historiador.

1834, un año inflamable

Para entender por qué la respuesta del modelo olía a calle, conviene asentar dos hechos. Primero, la Poor Law Amendment Act de 1834, una reforma que reorganizó la asistencia a los indigentes, agrupó parroquias en uniones y desplazó la ayuda hacia workhouses concebidas para disuadir a todo aquel que no estuviera realmente desesperado. La letra y el espíritu de la medida eran inequívocos, y ya entonces encendieron una oposición que dejaría huella documental durante décadas.

Segundo, el clima político y obrero del año quedó marcado por la causa de los Tolpuddle Martyrs. El 21 de abril de 1834, decenas de miles se congregaron en Copenhagen Fields, Islington, para exigir el perdón de seis trabajadores agrícolas transportados por jurar un “juramento ilícito” en el marco de una sociedad amistosa. Las estimaciones varían, desde 30.000 hasta cerca de 100.000 participantes. Hay grabados, crónicas y memoria material que lo recuerdan. El dato exacto importa menos que la escena: Londres, abril, una multitud ordenada marcha con peticiones gigantes rumbo a Westminster. La ciudad parecía un campamento armado, escribió más de un observador, y los organizadores hablaban de cientos de miles de firmas. Ese es el paisaje que un modelo bien alimentado con fuentes primarias puede recomponer sin citar explícitamente ninguna.

Y Palmerston, dirá el lector puntilloso. Henry John Temple, vizconde Palmerston, encarnaba el establishment liberal y fue secretario de Asuntos Exteriores en 1830 a 1834 y de nuevo a partir de 1835. No fue el autor de la nueva ley de pobres ni su adalid, pero su nombre circulaba en la política whig de la década y simbolizaba, para muchos, el poder distante al que se le reclamaba clemencia o reforma. A la vista de su relevancia, no extraña que TimeCapsuleLLM, al hablar de 1834 y tumultos, lo haya invocado como figura de fondo.

No hubo magia. Hubo emergencia estadística. En periódicos, panfletos, cartas y debates parlamentarios de 1834, se encuentran asociaciones reiteradas entre el año y vocablos como petition, poor relief, workhouse o riot. El modelo, expuesto cientos o miles de veces a esas coocurrencias, aprende que “1834” no es una cifra desnuda, sino un nudo semántico. Cuando recibe un prompt que lo activa, rellena con prosa verosímil ese espacio. A veces lo hará con precisión sorprendente, otras se alejará de los hechos. De ese vaivén surgió la constatación pedagógica que vale la pena transmitir: los LLM no recuperan registros, reconstruyen probabilidades.

Para evitar que el lector extrapole más de la cuenta, conviene distinguir “memoria” de “resonancia”. La máquina no guarda un archivo con “21 de abril de 1834, Copenhagen Fields”. Lo que memoriza son patrones de distribución. Por eso la verificación es indispensable cuando se utilizan modelos para hablar del pasado. Hansard, los archivos nacionales, museos o repositorios visuales permiten corroborar si la prosa que nos sedujo tiene anclaje en fuentes.

Del “desde cero” a cómo se implementó

Hay un detalle técnico que conviene afinar. Decir que el modelo se entrenó “desde cero” no significa que se haya inventado una arquitectura ex nihilo. Suele querer decir que no se partió de pesos preentrenados y que, en cambio, se usó una implementación minimalista tipo nanoGPT para entrenar un Transformer pequeño con datos propios. nanoGPT es un repositorio que reproduce GPT-2 con código conciso, ideal para experimentación en una sola GPU. Eso es “desde cero” en el sentido de los pesos, aunque no en el de la idea.

En paralelo, es útil mencionar otra línea de trabajo con modelos pequeños, como phi-1/phi-1.5 de Microsoft, una familia de Transformers entrenados con “textbook-quality data” sintético y curado, que mostró cómo la buena dieta, incluso sin web abierta, mejora razonamiento básico y reduce ruido. No es que TimeCapsuleLLM haya heredado sus pesos, pero la filosofía de datos limpios entronca con ese espíritu. Es, en miniatura, la misma apuesta: menos basura, más coherencia.

Quien quiera replicar la idea tiene un camino claro. Primero, curar un corpus que combine libros, panfletos, periódicos, debates y correspondencias. Segundo, tokenizar con un vocabulario afín a la época, sin términos posteriores que contaminen el registro. Tercero, entrenar un Transformer compacto con secuencias suficientemente largas para que el modelo capte tramas y no solo frases sueltas. Cuarto, evaluar con prompts temporales y con pruebas de “anacronismo negativo”, por ejemplo, midiendo si el modelo rechaza con naturalidad objetos que no existían en 1834. Quinto, documentar todo en una model card sobria: alcance, límites, riesgos, corte de datos, versión.

Para dimensionar: un modelo de unos cientos de millones de parámetros es abordable con una GPU de alquiler, siempre que el corpus esté limpio. Las curvas de pérdida no cuentan historias épicas, pero dicen si la máquina aprendió a hablar sin perder la compostura. Entre el overfitting a un periódico y la anemia lingüística de un vocabulario raquítico hay un punto de equilibrio que se encuentra iterando.

Historiografía computacional, o por qué medimos palabras

La cápsula de tiempo no solo sirve para fabular. Sirve para preguntar. Se puede medir la frecuencia relativa de “poor relief” o “workhouse” entre 1825 y 1840 y observar cómo varía alrededor de 1834. Se puede comparar el tono de “petition” antes y después de la marcha de Copenhagen Fields. Incluso, con cautela, se puede estudiar cómo cambió la adjetivación de la pobreza en periodismo y debates parlamentarios. Estas tareas no requieren fe en un oráculo, requieren protocolos replicables y un pie en las fuentes. Información de los Archivos Nacionales y los debates de Hansard ofrecen anclas firmes para situar esa curva en su contexto.

Un corpus del siglo XIX trae consigo el equipaje de su tiempo. Racismo, sexismo, colonialidad y clasismo asoman sin pedir permiso. Un modelo entrenado exclusivamente con esa prosa tenderá a reproducir ese mundo moral. La cápsula de tiempo, entonces, requiere filtros, advertencias y un marco de uso responsable. Hay cosas que conviene dejar en el depósito y no poner en exhibición sin contexto. A la vez, esa limitación es un recurso didáctico: permite mostrar cómo el lenguaje estructura realidades, cómo ciertas palabras legitiman instituciones, cómo la palabra “workhouse” suena a disciplinamiento antes que a cuidado. La historiografía posterior ya problematizó ese giro utilitarista de 1834 y la resistencia social que suscitó. Un modelo que lo dramatiza con verosimilitud puede ser pedagógico, siempre que no pretenda sustituir a los historiadores.

Aplicaciones y límites, con los pies en el empedrado

En educación, una IA victoriana permite conversar con un narrador de 1850 para explicar Dickens o contextualizar a Malthus. En investigación, se pueden trazar genealogías de conceptos y delinear mapas de coocurrencias que ilustren el aire del tiempo. En archivos y bibliotecas, estos sistemas ayudan a indexar fondos, detectar duplicados y sugerir rutas de lectura. La condición es siempre la misma: cotejo documental, cita, contraste.

Lo que no debe prometer, al menos por ahora, es reconstrucción forense de hechos. TimeCapsuleLLM no “sabe” que la procesión por Tolpuddle llevaba un carro con una petición gigantesca, aunque es probable que lo elabore si el prompt lo empuja. Que ese motivo aparezca en grabados y crónicas no lo convierte en memoria, lo convierte en coherencia estadística. Para pasar de lo plausible a lo probado, están los museos, las colecciones, los catálogos de imágenes y las actas parlamentarias.

La receta es corta y útil. Primera verificación, hecho mayor: que en 1834 se aprueba la nueva ley de pobres y que pone el énfasis en workhouses. Segunda, escena emblemática: que en abril de ese año se congregan decenas de miles en Copenhagen Fields por la causa de Tolpuddle. Tercera, matiz biográfico: que Palmerston era Foreign Secretary y no el diseñador de la ley. Con esas tres piedras queda marcado el terreno. Y con una cuarta, debates y cartas que expresan resistencia, se completa el cuadro. El resto es estilo.

[Ejemplo ficticio] “Las calles de Holborn hierven, señor. La nueva Ley de Pobres aprieta como un yugo, y en Islington las firmas se apilan como tablillas. Dicen que en Westminster escucharán”. Este tipo de salida ilustra lo que el modelo podría producir al activar el ancla “1834”. Lo correcto, después, es cotejar con fuentes y separar color local de contenido factual.

Ficha del modelo, sin pompa innecesaria

Ámbito: textos en inglés publicados entre 1800 y 1875, con foco en Londres, editados para OCR aceptable y metadatos básicos.

Objetivo: recrear registro lingüístico y asociaciones semánticas verosímiles de la época para fines didácticos y de exploración.

Riesgos: reproducción de sesgos de la época, alucinaciones plausibles, anacronismos cuando los prompts son ambiguos.

Límites de uso: no emplear salidas como evidencia histórica sin verificación independiente.

Corte de datos: 1875.

Arquitectura: Transformer pequeño, implementación estilo nanoGPT, entrenado desde pesos aleatorios. Sin herencia de pesos de modelos generales. Inspiración en el enfoque de datos curados de la familia phi.

Epílogo

TimeCapsuleLLM no viaja en el tiempo. Practica arqueología estadística. La pala es el tokenizador, el pincel es la atención, el estrato que aparece es 1834. Algunos días desentierra una joya, otros días solo te devuelve tejas rotas. Así funciona la investigación, así funciona la máquina. Y quizá por eso nos fascina: porque nos recuerda que el conocimiento no siempre es un archivo bien ordenado. A veces es una marcha, a veces es una petición, a veces es la intuición precisa de una IA que, educada en el siglo XIX, nos guiña un ojo y nos obliga a verificar

Referencias

-

Parlamento del Reino Unido. Poor Law Amendment Act, 1834 (4 & 5 Will. IV c. 76).

-

The National Archives (UK). “The New Poor Law, 1834” y recursos de contexto histórico.

-

Hansard. Debates de la House of Commons sobre el Poor Law Amendment Bill (sesiones de 1834).

-

Museum of London / British Library. Crónicas y grabados sobre la manifestación en Copenhagen Fields (abril de 1834) vinculada a los Tolpuddle Martyrs.

-

People’s History Museum; Tolpuddle Martyrs Museum. Materiales de interpretación histórica sobre el caso Tolpuddle y su recepción pública en 1834.

-

Oxford Dictionary of National Biography. Entrada “Temple, Henry John, third Viscount Palmerston”.

-

Vaswani, A. et al. (2017). “Attention Is All You Need”.

-

Karpathy, A. nanoGPT (repositorio y documentación técnica).

-

Microsoft Research. Documentación técnica de la familia phi (phi-1 / phi-1.5) y su enfoque de “textbook-quality data”.