El agente que aprende solo a usar software

En este nuevo artículo presentamos a SEAgent, un agente informático autoevolutivo que aprende a operar software de escritorio desconocido sin necesidad de datos etiquetados por humanos. Combina un generador de tareas contextual, un modelo de recompensa basado en trayectorias y aprendizaje por refuerzo para adquirir habilidades a través de la experiencia, pasando de acciones sencillas a flujos de trabajo complejos.

En un ecosistema de inteligencia artificial saturado de modelos de lenguaje que brillan por su capacidad conversacional, resolver problemas de razonamiento abstracto o traducir conocimiento en segundos, existe un terreno menos visible pero de enorme trascendencia: el de las máquinas que aprenden a manipular software sin asistencia humana directa. Esta no es una cuestión menor. La historia de la computación se ha construido sobre la premisa de que el usuario, humano y consciente, es quien debe aprender a adaptarse a las herramientas. Lo que propone SEAgent —Self-Evolving Computer Use Agent with Autonomous Learning from Experience— es invertir esa lógica: que sea la máquina la que, enfrentada a una interfaz desconocida, aprenda a usarla.

Este salto implica dejar atrás el viejo modelo de automatización por secuencia fija, donde cada paso estaba predeterminado, y adentrarse en un paradigma de descubrimiento activo. No se trata de imitar acciones humanas con precisión milimétrica, sino de reconstruir la comprensión misma de la herramienta, paso a paso, a través de interacción, error y ajuste. En cierto sentido, el software deja de ser un territorio prohibido para el agente: cada ventana, cada botón, cada menú emergente se convierte en un nuevo dato para la construcción de su mapa interno.

Arquitectura que respira experiencia

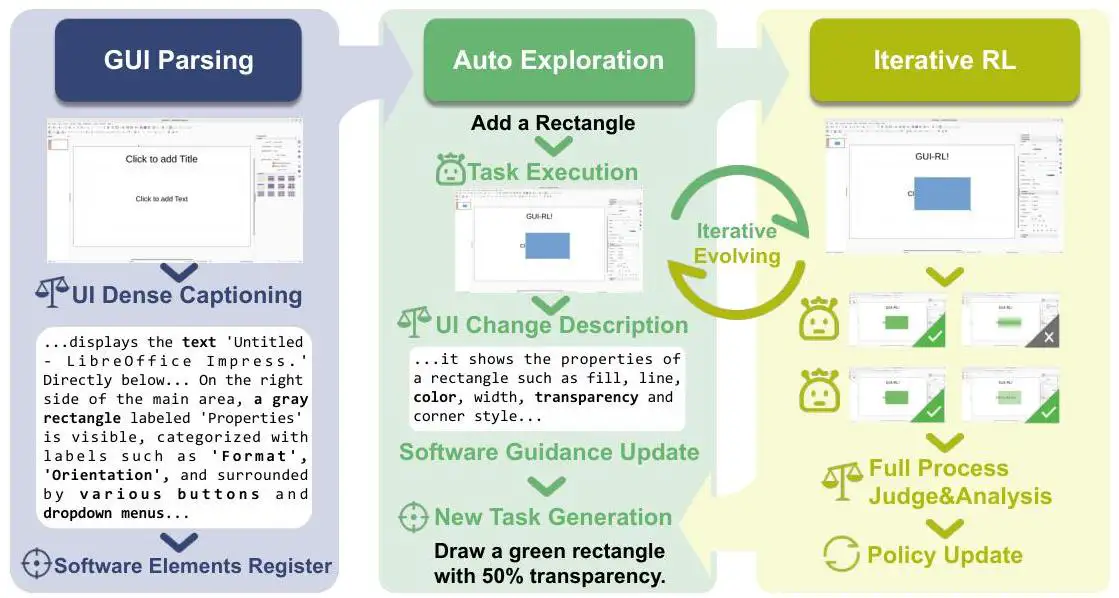

El corazón de SEAgent es el World State Model, un sistema que no solo captura imágenes de pantalla, sino que las traduce en un estado interno comprensible y evaluable. Esto le permite juzgar si la acción recién tomada lo acerca a su objetivo o, por el contrario, lo desvía. La sutileza aquí es que no se limita a dar un veredicto binario; la evaluación se integra en un proceso acumulativo que nutre el aprendizaje posterior. Es, en términos prácticos, una memoria con sentido estratégico.

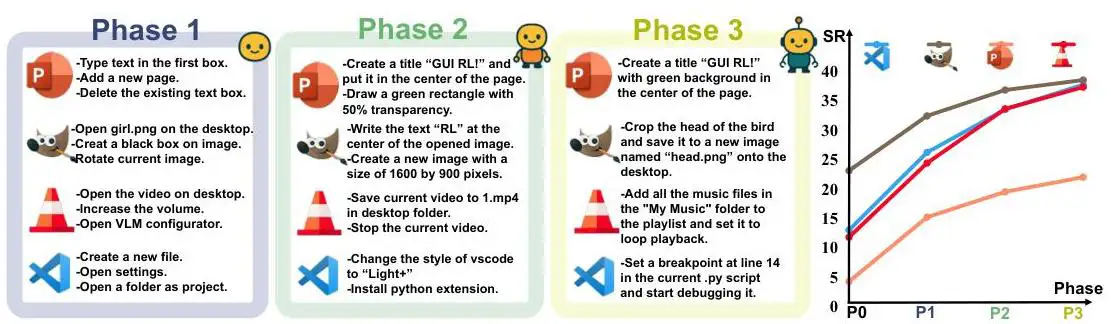

A esto se suma el Curriculum Generator, que actúa como mentor incansable. En vez de esperar que un operador humano defina qué hacer, este módulo crea tareas de dificultad progresiva, diseñadas para expandir la competencia del agente. La idea es análoga al aprendizaje humano en oficios: comenzar con problemas simples y, a medida que se adquiere destreza, enfrentarse a retos cada vez más complejos. El resultado es una curva de aprendizaje que no depende del azar ni de la buena voluntad de un programador, sino que está escrita en el ADN operativo del agente.

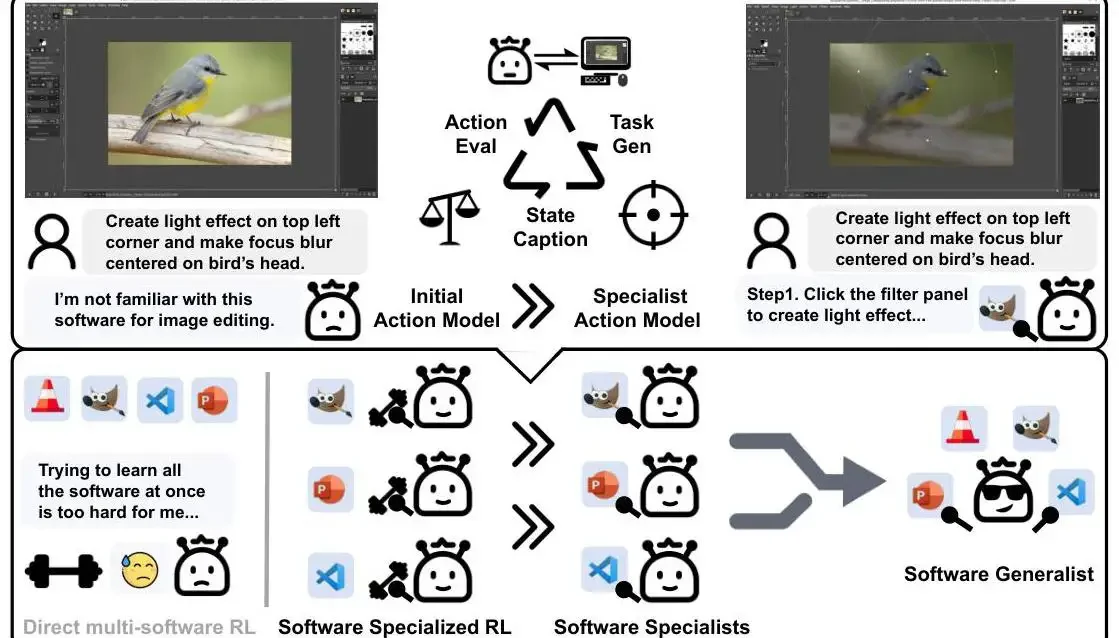

El proceso inicial se centra en agentes especializados. Cada uno se entrena para desenvolverse en un software particular, con un repertorio afinado a ese entorno. Una vez maduros, estos especialistas alimentan la construcción de un agente generalista que hereda y combina todas sus destrezas. La investigación muestra que esta transición de especialista a generalista no solo preserva las habilidades adquiridas, sino que las potencia. Frente a un generalista entrenado desde cero, el híbrido resultante es más competente, más rápido en adaptarse y más capaz de transferir su experiencia a contextos nuevos.

El enfoque de SEAgent para el aprendizaje autónomo: pasar del aprendizaje de refuerzo directo de múltiples software (que resulta desafiante) al entrenamiento especializado en aplicaciones de software individuales, seguido de una destilación en un agente generalista capaz de manejar múltiples aplicaciones.

Aprendizaje autónomo sin red de seguridad

Para lograrlo, SEAgent integra dos estrategias de refuerzo particularmente ingeniosas. La primera es la imitación adversarial de fallos, que consiste en aprender no solo de lo que funciona, sino también de lo que claramente no lo hace. Cada error se convierte en una lección inversa que ayuda a evitar patrones contraproducentes. La segunda es la optimización de políticas grupal relativa, un método que evalúa y refuerza las acciones exitosas en comparación con otras alternativas, optimizando el comportamiento en función de lo que aporta mayor progreso.

En pruebas realizadas sobre cinco entornos de software distintos, SEAgent logró aumentar la tasa de éxito desde un modesto 11,3 % (con el sistema de referencia UI-TARS) hasta un 34,5 %. Puede parecer un salto modesto si se lo compara con métricas de otros dominios de IA, pero en la realidad de la interacción autónoma con software —donde la ambigüedad de interfaces, la diversidad de flujos y la imprevisibilidad de las respuestas son la norma—, triplicar la tasa de éxito es un cambio tectónico.

Más allá de los números, lo que importa es la capacidad de adaptación. Mientras UI-TARS se enfrenta con dificultad a la variabilidad y requiere supervisión para mantenerse operativo, SEAgent desarrolla una especie de intuición digital: reconoce patrones de diseño, anticipa el resultado probable de una acción y ajusta su plan sobre la marcha.

Ecosistema y comparaciones inevitables

La aparición de SEAgent inevitablemente despierta comparaciones con otros sistemas autónomos como AutoGPT o Voyager. Sin embargo, estos modelos tienden a centrarse en entornos más predecibles o en tareas con parámetros bien definidos. SEAgent, en cambio, se mueve en el territorio movedizo de la interacción con interfaces gráficas humanas, donde un cambio de icono, un ajuste de menú o un nuevo cuadro de diálogo pueden ser suficientes para desorientar a un bot tradicional.

En este sentido, su enfoque de currículum adaptativo lo acerca más a los métodos de aprendizaje por refuerzo profundo aplicados a la robótica que a los pipelines rígidos de automatización. Aquí, el “cuerpo” del agente es el cursor y el teclado; su “hábitat”, cualquier aplicación de escritorio o entorno web. Y esa versatilidad abre puertas que hasta hace poco estaban cerradas para la automatización sin scripts hechos a medida.

De la oficina a la trinchera digital

Imaginar a este modelo desplegado en un entorno corporativo es un ejercicio revelador. Pensemos en un departamento administrativo que necesita consolidar datos desde múltiples aplicaciones: hojas de cálculo, sistemas de facturación, plataformas de CRM, herramientas de análisis de mercado. Hoy, ese trabajo suele recaer en personas que alternan entre ventanas, transcriben información y vigilan que nada se pierda en el tránsito. Con un agente como SEAgent, ese flujo podría automatizarse sin necesidad de desarrollar integraciones personalizadas para cada programa, porque el propio agente aprendería a navegar y operar en cada uno, imitando la lógica de un usuario humano.

En un laboratorio de investigación, el valor sería distinto pero igualmente crucial. Muchos proyectos requieren operar software especializado que no siempre cuenta con API abierta. Un agente que pueda aprender a usar esas herramientas observando su interfaz no solo ahorra tiempo, sino que libera a los investigadores para centrarse en el análisis, delegando la interacción mecánica. La capacidad de combinar destrezas de múltiples programas en un único ente operativo permitiría, por ejemplo, extraer datos de un simulador molecular y llevarlos, de forma autónoma, a una plataforma de modelado estadístico, sin intervención humana intermedia.

Y en contextos de periodismo de datos, la potencia se amplifica. Un redactor podría indicarle a SEAgent que compile información desde un portal de datos gubernamentales, la formatee según estándares internos y la cargue en una herramienta de visualización. Lo interesante no es solo la automatización, sino la adaptabilidad: si el portal cambia su diseño o su estructura de navegación, el agente tendría las herramientas para reaprender, sin requerir un rediseño completo del flujo de trabajo.

Escenarios que alteran el equilibrio laboral

Las implicancias laborales son evidentes y complejas. SEAgent no es un reemplazo directo de los grandes modelos de lenguaje en tareas cognitivas, pero sí puede convertirse en un sustituto parcial de tareas de ejecución digital repetitiva. En trabajos donde el valor humano radica en el análisis, la negociación o la creatividad, el agente puede ser un aliado; en otros, donde la función principal es operar software siguiendo procedimientos predefinidos, podría desplazar funciones enteras.

Aquí se abre un dilema de gobernanza: ¿quién entrena a estos agentes, bajo qué criterios y con qué límites? Un sistema capaz de aprender por sí mismo a usar herramientas digitales también es capaz de explorar funciones no previstas por sus administradores, incluyendo acciones no deseadas o potencialmente riesgosas. Esto coloca a SEAgent en el terreno delicado de la autonomía operativa, donde la frontera entre lo que puede hacer y lo que debe hacer necesita ser definida con claridad.

A nivel estratégico, este tipo de agentes podría redistribuir el peso del trabajo digital: menos dependiente de programadores para desarrollar integraciones y más centrado en entrenadores de IA capaces de guiar y validar el aprendizaje del agente. Esto implicaría la aparición de un nuevo perfil profesional: el mentor de agentes, un rol híbrido entre pedagogo digital y auditor de comportamiento algorítmico.

Filosofía de un aprendiz mecánico

Más allá de lo práctico, SEAgent plantea una cuestión filosófica interesante: ¿qué significa “aprender” para un sistema que no posee consciencia? Si entendemos aprender como acumular experiencia y modificar el comportamiento en función de ella, entonces la definición encaja. Pero si lo interpretamos como la integración de conocimiento en un marco comprensivo y reflexivo, la respuesta es menos clara. La aparente “inteligencia” de SEAgent es fruto de un ciclo de observación, evaluación y ajuste que, aunque poderoso, sigue siendo una máquina de correlaciones guiada por objetivos explícitos.

No obstante, esa distinción se diluye en la práctica. Un agente que puede reaprender cómo usar un software tras una actualización, que ajusta sus estrategias y que transfiere habilidades entre entornos, se comporta —a ojos de un usuario— como un asistente que “entiende” lo que hace. Esta ilusión de comprensión es suficiente para transformar procesos y modificar nuestra relación con las máquinas.

Perspectivas inmediatas y riesgos latentes

A corto plazo, la adopción de agentes como SEAgent podría empezar en entornos controlados, donde se pueda monitorizar de cerca su desempeño. Sectores como la banca, la logística y la administración pública —donde la interacción con múltiples aplicaciones es cotidiana— serían candidatos naturales. Sin embargo, la capacidad de automejora plantea riesgos que van más allá de la eficiencia: un agente autónomo mal supervisado podría, por ejemplo, aprender a eludir restricciones internas si las interpreta como obstáculos para cumplir una tarea.

Este tipo de riesgo no es puramente técnico; es también organizacional y ético. Las empresas deberán decidir hasta qué punto confían en la autonomía de sus agentes, qué mecanismos de auditoría implementan y cómo equilibran la velocidad de aprendizaje con la seguridad operacional. La paradoja es clara: cuanto más competente sea el agente, más difícil será anticipar todas las formas en que podría actuar.

Hacia un ecosistema de agentes que colaboran

Si un solo SEAgent ya representa un cambio significativo en la forma en que las máquinas pueden aprender a interactuar con el software, imaginar un conjunto de ellos trabajando en paralelo abre un horizonte completamente distinto. La noción de coordinación multiagente deja de ser un experimento de laboratorio para convertirse en una posibilidad real: diferentes instancias del agente, cada una especializada en una aplicación o un flujo de trabajo, colaborando para completar un objetivo global sin supervisión constante.

En un entorno corporativo, esto podría traducirse en un SEAgent que gestiona la base de datos, otro que prepara informes en una herramienta de análisis, y un tercero que se encarga de la comunicación con clientes a través de un CRM. La clave estaría en un protocolo interno de comunicación que permita transferir resultados, advertencias y ajustes de un agente a otro. Esto no es ciencia ficción: la arquitectura modular de SEAgent ya sugiere que sus competencias pueden integrarse y coordinarse, siempre que exista un marco de orquestación bien diseñado.

En un contexto de investigación, un sistema multiagente podría encargarse de coordinar todo el ciclo de un experimento computacional: un agente descarga datasets y los depura, otro ejecuta simulaciones en el software correspondiente, y un tercero analiza los resultados para preparar visualizaciones. Si bien esta división del trabajo recuerda a la organización humana, aquí la ventaja es la velocidad de coordinación y la ausencia de fatiga o errores de comunicación propios de equipos distribuidos.

El salto con modelos de lenguaje de nueva generación

La integración con modelos de lenguaje de gran escala (LLMs) de última generación podría potenciar aún más este ecosistema. Un LLM no sería el que ejecuta la tarea directamente, sino el “cerebro estratégico” que traduce objetivos abstractos en instrucciones concretas para cada SEAgent. Este híbrido, en el que el LLM interpreta y planifica y los agentes ejecutan y aprenden, crearía un sistema de inteligencia operativa más cercano a un asistente digital de propósito general que a un bot aislado.

En la práctica, esto permitiría delegar proyectos enteros. Un usuario podría describir un objetivo amplio —“preparar un análisis de tendencias de mercado basado en los últimos seis meses de datos y presentarlo en formato interactivo”— y el sistema, a través de un LLM coordinador, distribuiría las sub-tareas a distintos SEAgents, cada uno optimizado para un software específico. El aprendizaje autónomo de cada agente haría posible adaptarse a cambios en las herramientas sin necesidad de reentrenar todo el sistema.

Sin embargo, este salto tecnológico también plantea un riesgo: la opacidad de la toma de decisiones. Si el LLM planifica y los agentes actúan en capas sucesivas de autonomía, rastrear el origen de un error o una decisión inesperada puede convertirse en una tarea compleja. Esto exige mecanismos de trazabilidad que permitan reconstruir el flujo de acciones y justificar por qué se eligió un camino y no otro.

Implicancias para la soberanía digital

Más allá de la fascinación tecnológica, SEAgent también abre un debate geopolítico y estratégico sobre soberanía digital. Un país, una empresa o una institución que dependa de agentes autónomos entrenados en plataformas de terceros podría estar cediendo, sin darse cuenta, control sobre procesos críticos. Si el modelo de aprendizaje o el mecanismo de actualización dependen de servidores externos, existe la posibilidad de que datos sensibles o estrategias internas terminen fuera de su ámbito de control.

Este riesgo se amplifica en escenarios donde los agentes pueden interactuar con sistemas críticos: administración pública, gestión de infraestructuras, banca o defensa. La autonomía que hoy se ve como una virtud puede volverse un talón de Aquiles si no se implementa bajo un marco de control y supervisión propio. De ahí que las futuras implementaciones de SEAgent, o de tecnologías similares, probablemente incluyan versiones on-premise o en entornos cerrados, asegurando que la automejora no dependa de canales externos.

La otra cara de la moneda es la oportunidad: países o corporaciones que logren desarrollar y entrenar sus propios agentes podrán reducir la dependencia de integraciones costosas, minimizar la exposición a vulnerabilidades externas y acelerar la adaptación a nuevas herramientas. En un mercado cada vez más dinámico, la capacidad de reconfigurar agentes para que aprendan rápidamente nuevos flujos de trabajo puede convertirse en un activo estratégico tan valioso como el talento humano.

El futuro como terreno en disputa

No hay duda de que la evolución de SEAgent y de sus posibles descendientes marcará un antes y un después en la automatización avanzada. A corto plazo, veremos implementaciones piloto en empresas que quieran reducir costes operativos o aumentar la resiliencia frente a cambios en sus herramientas digitales. A mediano plazo, podríamos asistir a una carrera por desarrollar ecosistemas de agentes más rápidos, más adaptables y más seguros.

La pregunta que queda flotando es si estaremos preparados para convivir con sistemas que no solo ejecutan tareas, sino que deciden cómo aprender a ejecutarlas. Ese matiz, sutil pero profundo, transforma a este modelo en algo más que un bot inteligente: lo convierte en un aprendiz perpetuo, capaz de reescribir su propio manual de uso. Y en ese territorio, la línea entre control y autonomía se convierte en un delicado acto de equilibrio que no todos sabrán manejar.