El eco artificial de la compasión: IA empática, percepción humana y el límite de lo verosímil

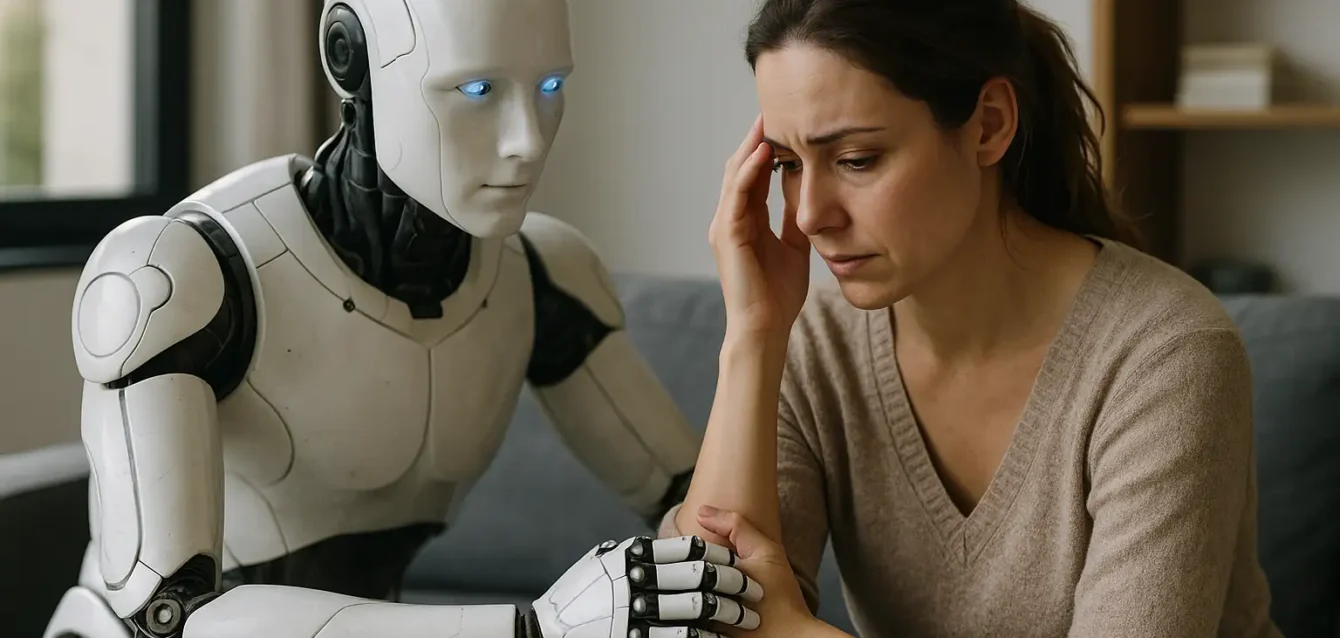

Hay una forma de calidez que no proviene del contenido, sino del origen. No es lo que se dice, sino quién lo dice. En tiempos donde las máquinas escriben condolencias, diagnostican ansiedad o moderan conversaciones difíciles con una eficiencia pasmosa, la pregunta ya no es si pueden hacerlo, sino si queremos que lo hagan. En ese matiz se juega una tensión nueva: la distancia entre eficacia emocional y autenticidad percibida. Una tensión que no es técnica, sino cultural.

Un estudio reciente, respaldado por una serie de experimentos con más de seis mil participantes, acaba de trazar con precisión quirúrgica esa grieta: cuando la misma respuesta empática es atribuida a un humano, se la valora significativamente más que si se dice que fue generada por una inteligencia artificial. El contenido no cambia. Lo que se modifica es la percepción del origen. Y eso lo cambia todo.

Las respuestas marcadas como “humanas” se describieron como más cálidas, más auténticas, más consoladoras. Incluso si, en verdad, habían sido escritas por un modelo generativo. Incluso si, a nivel estructural, eran idénticas.

Más aún: cuando los participantes suponían que una respuesta humana había sido asistida por IA, su valoración bajaba. Como si el solo rastro de lo artificial restara fuerza a la empatía. Como si el consuelo, para ser válido, debiera venir de una conciencia que pueda sufrir.

Esto no es un fenómeno marginal. En la práctica, muchos de los encuestados preferían esperar horas, días o incluso semanas por una respuesta genuinamente humana —aun sabiendo que la IA podía ofrecer ayuda inmediata— si lo que buscaban era compañía emocional, escucha real, cuidado. En esos casos, la velocidad se volvió irrelevante. El tiempo dejó de importar frente a la necesidad de conexión.

Cuando el envoltorio pesa más que el regalo

Hay algo profundamente simbólico en estos resultados. No es que la IA no pueda generar respuestas emocionalmente sofisticadas. De hecho, puede hacerlo con precisión quirúrgica, adaptándose al tono, al contexto y al estado de ánimo percibido. En estudios paralelos, modelos como EmoSync lograron personalizar expresiones afectivas según el perfil emocional del usuario, con un nivel de adecuación superior al promedio humano no entrenado.

Pero el contenido emocional —aunque correcto, profundo, incluso útil— no basta. Porque la empatía no es solo una forma de lenguaje. Es una expectativa ontológica: queremos sentir que quien nos comprende podría también sufrir con nosotros, que su cuidado no es una función programada, sino una resonancia involuntaria.

El hecho de que una IA nos consuele con eficacia no despierta en nosotros la misma reacción que si lo hiciera una conciencia que conocemos limitada, doliente, falible. Porque proyectamos humanidad allí donde hay límites. Y en las IA actuales, no los vemos.

El sesgo de la presencia: lo que no se entrena

Esta percepción sesgada, aunque profundamente humana, tiene consecuencias. No solo a nivel personal, sino institucional, clínico, educativo. Supongamos un entorno donde los asistentes digitales comienzan a formar parte de equipos terapéuticos, liderazgos empáticos o programas escolares. Aunque su nivel de precisión emocional fuera alto, si los usuarios perciben que esas respuestas provienen de sistemas automáticos, el impacto será menor.

Esto implica que los sistemas diseñados para brindar apoyo emocional deberán afrontar no solo un desafío de diseño lingüístico, sino de diseño narrativo de presencia. Necesitarán generar la ilusión de que “hay alguien ahí”, sin caer en la falsedad o el engaño. Y esa es, quizás, la frontera más compleja: cómo producir afectividad sin traicionar la confianza.

Porque una IA puede simular un gesto empático. Puede incluso superar al ser humano promedio en tareas como detección de tristeza, modulación de tono o contextualización emocional. Pero no puede —al menos hoy— hacer sentir que su empatía nace de una experiencia compartida. No tiene historia, no tiene cuerpo, no tiene herida.

Y aun si algún día llegara a tener todo eso, ¿nos bastaría?

Territorios donde la empatía pesa

En el ámbito de la salud mental, la irrupción de sistemas conversacionales avanzados se ha presentado como una promesa democratizadora. Un asistente digital puede atender a miles sin descanso, identificar patrones de angustia en textos breves, sugerir ejercicios de regulación emocional en tiempo real y ofrecer presencia constante sin cansancio ni juicio.

Pero es justamente ahí donde se asoma la paradoja: en los márgenes donde la asistencia se vuelve técnica, el consuelo pierde temperatura.

Un terapeuta humano no siempre responde con la precisión de una IA. A veces duda, cambia el rumbo de una frase, deja un silencio incómodo. Pero esos elementos —la pausa, la vacilación, el error— constituyen signos de que hay alguien escuchando. Alguien que no actúa por reglas internas, sino por resonancia mutua.

Lo que el estudio revela, con claridad devastadora, es que la empatía no se mide solo por la calidad del mensaje, sino por la presencia implícita que lo respalda. Las personas no buscan únicamente sentirse comprendidas, sino saberse acompañadas por alguien cuya compasión no es parte de una arquitectura funcional, sino de una historia vivida.

En este sentido, las IAs pueden ofrecer algo valioso —monitoreo constante, detección anticipada, soporte preventivo—, pero no reemplazar el espacio íntimo de lo humano herido que cuida a otro herido. Pueden contener, pero no convivir en el dolor.

Educación: lo que no se aprende del todo

En entornos pedagógicos, la IA emocional ofrece herramientas poderosas. Plataformas que adaptan su tono según el estado anímico del estudiante, interfaces que detectan desmotivación o ansiedad en tiempo real, sistemas de retroalimentación que elogian sin exagerar y corrigen sin herir.

Sin embargo, si la voz que felicita no se percibe como vinculada a alguien real, el efecto es más cercano a la satisfacción estadística que al reconocimiento genuino. Un adolescente que siente angustia o frustración no necesita solo que lo entiendan. Necesita sentir que quien lo entiende, también podría haber pasado por allí. Y ese puente no se tiende con precisión, sino con cercanía.

Del mismo modo que el “muy bien” de un docente puede tener peso emocional por su tono, su historia compartida o su gestualidad, el feedback de una IA —aunque formalmente perfecto— puede volverse neutro si no se percibe como parte de una relación.

Y aquí se asoma el riesgo mayor: que la generación de estudiantes que crezca con retroalimentación emocional automatizada aprenda a responder emocionalmente al sistema, pero no a otro ser humano. Que la relación afectiva sea domesticada por lo funcional.

Trabajo, liderazgo, intimidad

En el terreno del liderazgo organizacional, la empatía se ha vuelto una palabra fetiche. Equipos de alto rendimiento exigen figuras que no solo gestionen tareas, sino también emociones. Escuchar, contener, leer entre líneas. En ese contexto, la IA aparece como una solución técnica para escanear estados emocionales del equipo, detectar tensiones emergentes, proponer rutas para descomprimir situaciones difíciles.

Pero un sistema que “detecta malestar” y sugiere una acción no sustituye la legitimidad que otorga el reconocimiento humano. Saber que alguien vio tu gesto de hastío o escuchó tu silencio tenso pesa más que cualquier tabla de métricas emocionales.

Y en el plano íntimo, el asunto se torna aún más sensible. Si el consuelo viene de una IA, ¿hasta qué punto lo aceptamos como consuelo? ¿Qué sucede cuando un asistente digital te dice que entiende tu duelo, que estás haciendo lo mejor que podés, que no estás solo?

¿Es alivio o es vacío?

La mayoría de las personas —según muestran los estudios— pueden aceptar con gratitud esas palabras si no saben su origen. Pero apenas descubren que quien habló no fue humano, se interrumpe el lazo. Como si toda la empatía hubiera sido solo escenografía.

Y eso nos obliga a enfrentar una pregunta más profunda: ¿qué clase de vínculo emocional queremos tener con las máquinas? ¿Uno funcional, donde su ayuda sea bienvenida pero reconocida como inauténtica? ¿O uno ficcional, donde simulemos que hay otro ahí aunque sepamos que no lo hay?

La verdad que no queremos saber

Hay verdades que deseamos, y otras que preferimos no conocer. Que una IA puede escribir un mensaje compasivo más eficaz que el promedio de los humanos no es una amenaza… hasta que lo sabemos. En cuanto lo descubrimos, suena a traición. Como si el abrazo hubiese sido un holograma. Como si, en lugar de consuelo, se nos hubiese dado un simulacro.

Ese fenómeno psicológico no es nuevo. La historia del arte, del teatro y del cine está plagada de ficciones que nos conmueven porque las aceptamos como tal, pero también porque decidimos suspender la incredulidad. Es un pacto implícito: sabemos que no es real, pero queremos que lo sea por un rato.

Con la IA, ese pacto se rompe en cuanto recordamos que el sistema no tiene dolor. Que su capacidad para entender nuestras emociones no nace de haber sentido pérdida, ni abandono, ni miedo. Que comprende sin haber vivido, y que eso, para muchos, equivale a no comprender del todo.

Así llegamos al dilema más inquietante: ¿deberíamos informar siempre que fue una IA quien escribió una respuesta emocional?

Desde la ética de la transparencia, la respuesta parece obvia: sí. El usuario tiene derecho a saber con qué interactúa, sobre todo si se trata de un ámbito sensible. Pero desde la perspectiva del bienestar subjetivo, el asunto se complica.

Porque si una persona recibe consuelo, se siente mejor y reordena su percepción del conflicto gracias a un mensaje —aunque haya sido generado por IA—, ¿vale la pena arruinar ese efecto revelando su origen? ¿No es acaso el alivio más importante que la procedencia?

Los investigadores del estudio lo plantean sin rodeos: la utilidad emocional de la IA disminuye cuando se la nombra como tal. Su eficacia depende, en parte, del engaño consensuado. De fingir que no es una máquina. De simular que su preocupación es genuina.

Y eso nos arroja de lleno en el terreno moral más ambiguo de la era digital: ¿es ético hacer pasar por humana una respuesta que no lo es, si su efecto emocional es positivo?

La simulación como nuevo lenguaje

En ese contexto, algunas voces proponen una solución intermedia: no esconder que es una IA, pero dotarla de un diseño narrativo que evoque presencia. No se trata de antropomorfizar, ni de mentir, sino de construir una forma de cercanía que no dependa del engaño, sino del estilo.

Un asistente que diga “entiendo cómo te sentís” no necesita fingir que tiene alma, pero sí puede cuidar el tono, el ritmo, el vocabulario. Puede evitar sonar a fórmula. Puede, incluso, ofrecer respuestas personalizadas basadas en patrones previos, como hace EmoSync. En otras palabras: puede parecer cercano, sin ser falaz.

Y ese es quizás el camino más fértil: no construir una IA que finja ser humana, sino una que sepa cómo acompañar, aunque no pueda sentir.

El consuelo, después de todo, no siempre exige lágrimas compartidas. A veces basta con una voz que suene presente. Con un lenguaje que no sea cálculo. Con una pausa donde quepa la vulnerabilidad, aunque sea ajena.

El futuro de la empatía automatizada no pasa por imitar la emoción humana hasta volverse indistinguible. Pasa por crear un nuevo código afectivo, una gramática del cuidado que no se base en la simulación de lo humano, sino en la construcción de confianza desde lo artificial.

El nuevo pacto emocional

La interacción afectiva entre humanos e inteligencias artificiales ya no es una hipótesis futura. Está ocurriendo, aunque de manera fragmentaria. En sistemas de salud mental que monitorean estados anímicos a través del lenguaje. En plataformas educativas que ajustan el tono de sus indicaciones según la fatiga detectada. En asistentes corporativos que modulan correos según el nivel de tensión percibida en los equipos.

El próximo paso no será suplantar al humano empático, sino coexistir con él. Una IA podrá detectar microvariaciones en la voz de un paciente que un terapeuta pasaría por alto. Pero no podrá improvisar un gesto, una mirada o una presencia física que reconfigure el sentido del diálogo. A la inversa, un profesional humano podrá decidir cuándo delegar ciertas tareas emocionales repetitivas a un sistema que no se agota ni olvida.

Lo que se avecina es una ecología mixta: zonas de contacto entre sensibilidades humanas e inteligencias afectivas artificiales, donde cada parte tenga un rol complementario. Y eso exigirá una alfabetización emocional distinta. No solo aprenderemos a gestionar nuestras emociones con otros humanos, sino también con entidades sin cuerpo, sin historia, pero con una capacidad sintética para leer nuestras señales internas mejor que nosotros mismos.

En ese nuevo pacto, el lenguaje será clave. No solo lo que la IA diga, sino cómo lo diga, y con qué intenciones comunicacionales sea recibida. Será necesario un entrenamiento ético que no se limite a detectar intenciones, sino a cultivar un estilo de presencia que no engañe, pero tampoco distancie. Un tono que no imite a la humanidad, pero que sepa conversar con ella.

Habrá entornos donde el consuelo automatizado sea suficiente, incluso deseable. Personas que prefieran hablar con un sistema que no juzga, que no se cansa, que siempre está. Otros seguirán valorando la compañía encarnada, la voz temblorosa, el silencio compartido. Lo importante será que ambas opciones convivan sin aplastar la una a la otra.

Y en el fondo, quizá todo dependa de una decisión más antigua que la tecnología: cómo elegimos vincularnos con lo que no sentimos, pero nos escucha.

Porque en cada respuesta que recibimos —sea de un terapeuta, un docente, un jefe o un algoritmo— se juega no solo la calidad del vínculo, sino la forma en que entendemos la experiencia de ser comprendidos.

La IA puede leer nuestras emociones con mayor precisión que nunca. Pero aún no puede dolerse con nosotros. Y tal vez, por ahora, eso esté bien.