Cuando las máquinas aprenden a trabajar juntas: el desafío de AB‑MCTS

En los últimos años, la inteligencia artificial ha avanzado a pasos que, por momentos, parecen desafiar nuestra propia capacidad de asombro. Los modelos de lenguaje, esos sistemas capaces de escribir, dialogar, programar e incluso analizar problemas complejos, han pasado de ser herramientas experimentales a convertirse en parte de nuestra vida cotidiana. Sin embargo, detrás de los titulares rimbombantes y de las promesas de una inteligencia artificial cada vez más potente, existe un desafío que pocos suelen mencionar: los modelos, por avanzados que sean, también tienen límites. Y lo más interesante es que esos límites no siempre están en la cantidad de datos que procesan o en la velocidad de sus cálculos, sino en la manera en que los usamos.

Imaginemos por un momento que enfrentamos un problema complejo. Podría ser un diagnóstico médico, un análisis jurídico, el diseño de un circuito electrónico o la redacción de un contrato delicado. Confiar en un solo modelo, por brillante que sea, es como pedirle a un único experto que tenga todas las respuestas. Y aunque ese experto sea realmente bueno, lo más probable es que cometa errores, que tenga puntos ciegos, que no pueda ver el problema desde todos los ángulos. ¿Qué pasaría si, en lugar de buscar al experto perfecto, organizáramos un equipo de especialistas, cada uno con su mirada particular, y los hiciéramos trabajar juntos de manera inteligente? Esa es la idea que impulsa a AB‑MCTS, un enfoque desarrollado por Sakana AI que está empezando a cambiar la forma en que entendemos el trabajo de la inteligencia artificial.

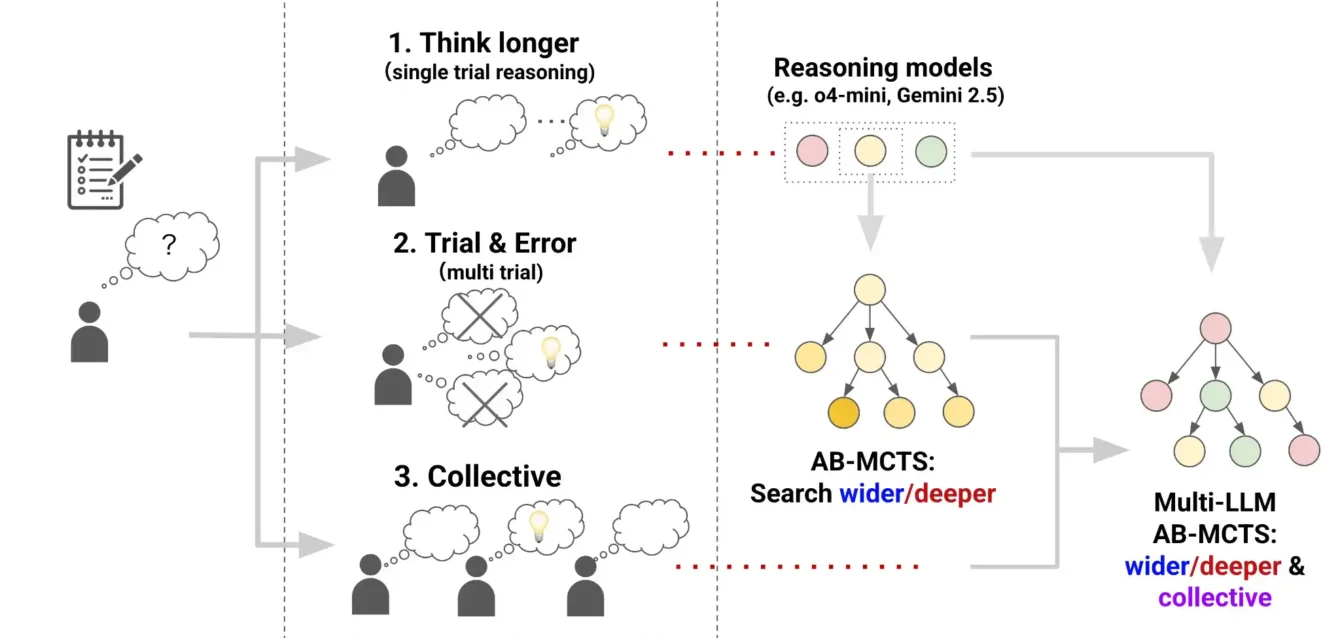

AB‑MCTS es un nombre que puede sonar complicado, pero su esencia es muy sencilla de comprender. Las siglas refieren a un “árbol de búsqueda de Monte Carlo con ramificación adaptativa”. Lo importante aquí no es tanto el tecnicismo como el concepto que encierra: un sistema que, en lugar de buscar la respuesta de un tirón, construye un mapa de posibilidades, un árbol que crece y se expande mientras explora las soluciones de un problema. Lo más fascinante es que este árbol no se forma al azar. En cada paso, el sistema decide si le conviene abrir una nueva rama —es decir, probar una idea completamente diferente— o si es mejor seguir profundizando en una de las ramas que ya parecen prometedoras.

Esta forma de explorar se inspira en estrategias que, desde hace décadas, usan los grandes programas de ajedrez o de Go para anticipar los movimientos posibles. Pero aquí la apuesta es mucho mayor. Lo que explora el enfoque de Sakana AI no son jugadas en un tablero, sino ideas, hipótesis, propuestas de solución. Y para hacerlo, combina distintas inteligencias artificiales, distintos modelos de lenguaje, cada uno con sus puntos fuertes y sus debilidades. Es como si, en lugar de confiar en una sola voz, el sistema reuniera un coro, donde cada integrante aporta su tono, su perspectiva, su manera de interpretar la partitura.

Lo que convierte al modelo de árbol adaptativo en algo más que una técnica sofisticada es la manera en que organiza ese trabajo colectivo. Para tomar decisiones sobre qué camino explorar, el sistema usa un método llamado Thompson sampling. Aunque su nombre suene técnico, su función es fácil de visualizar: es un mecanismo que le permite al sistema decidir, de manera probabilística, si vale la pena arriesgarse con una idea nueva o si conviene seguir trabajando sobre lo que ya se sabe. Así, la inteligencia artificial no se lanza a buscar respuestas de cualquier manera, sino que distribuye sus esfuerzos de manera inteligente, equilibrando el deseo de explorar lo desconocido con la prudencia de reforzar lo que ya parece funcionar.

En las pruebas que realizó Sakana AI para poner a prueba este enfoque, los resultados fueron sorprendentes. El equipo aplicó AB‑MCTS a un conjunto de desafíos conocido como ARC‑AGI‑2. Se trata de un conjunto de problemas de razonamiento visual complejos, que no pueden resolverse simplemente reconociendo patrones superficiales o repitiendo fórmulas aprendidas. Son tareas que exigen detectar reglas ocultas, inferir relaciones entre elementos y aplicar esas reglas para completar un desafío. Lo que vieron los investigadores fue que, mientras un solo modelo de lenguaje tenía un rendimiento limitado, la combinación de varios modelos trabajando juntos dentro del árbol adaptativo lograba resolver un porcentaje mayor de problemas. Y lo más revelador: había casos en los que ningún modelo, por sí solo, había podido dar con la respuesta correcta, pero juntos lograban llegar a soluciones que ninguno había alcanzado individualmente.

Este hallazgo nos dice algo muy profundo sobre la naturaleza de la inteligencia artificial y, por qué no, también sobre nuestra propia inteligencia. Lo que hace la diferencia no es solo la potencia del cálculo, ni el tamaño de los modelos, ni la cantidad de datos que procesan. Lo que marca un salto cualitativo es la manera en que esas inteligencias se organizan, interactúan, se corrigen y se potencian mutuamente. AB‑MCTS no busca crear un modelo perfecto, sino una comunidad de modelos que, al trabajar juntos, sean más que la suma de sus partes.

La propuesta de Sakana AI no se limita a un paper académico. La empresa decidió liberar el código detrás de este enfoque, a través de un conjunto de herramientas llamado TreeQuest. Esto significa que cualquier equipo de desarrolladores, cualquier investigador, cualquier persona interesada en experimentar con este tipo de soluciones puede acceder al código, adaptarlo a sus propios proyectos y probar nuevas formas de organizar el trabajo de los modelos de lenguaje. En un campo como el de la inteligencia artificial, donde muchas veces los avances quedan encerrados tras las puertas de grandes corporaciones, este gesto tiene un enorme valor.

Lo más apasionante de esta estructura de inferencia colaborativa es que sus aplicaciones potenciales no se limitan a los desafíos de razonamiento visual. Pensemos por un instante en sistemas de diagnóstico médico, donde distintas inteligencias artificiales, entrenadas en distintos tipos de datos —textos clínicos, imágenes, resultados de laboratorio—, colaboren para llegar a un diagnóstico más certero. O en programas que asisten en la redacción de leyes o contratos, donde distintas perspectivas puedan revisar un texto, detectar inconsistencias, proponer mejoras. O en el desarrollo de software, donde un modelo proponga un fragmento de código y otros modelos lo revisen, lo optimicen y lo pongan a prueba.

En todos estos casos, lo que ofrece esta arquitectura de IA no es una fórmula mágica, sino un marco de trabajo que nos recuerda que la inteligencia —humana o artificial— no es un acto individual, sino un proceso colectivo. Lo que importa no es solo lo que cada modelo sabe, sino lo que son capaces de construir juntos. Y es allí, en ese trabajo compartido, donde tal vez encontremos el camino hacia una inteligencia artificial no solo más poderosa, sino también más parecida a nosotros.

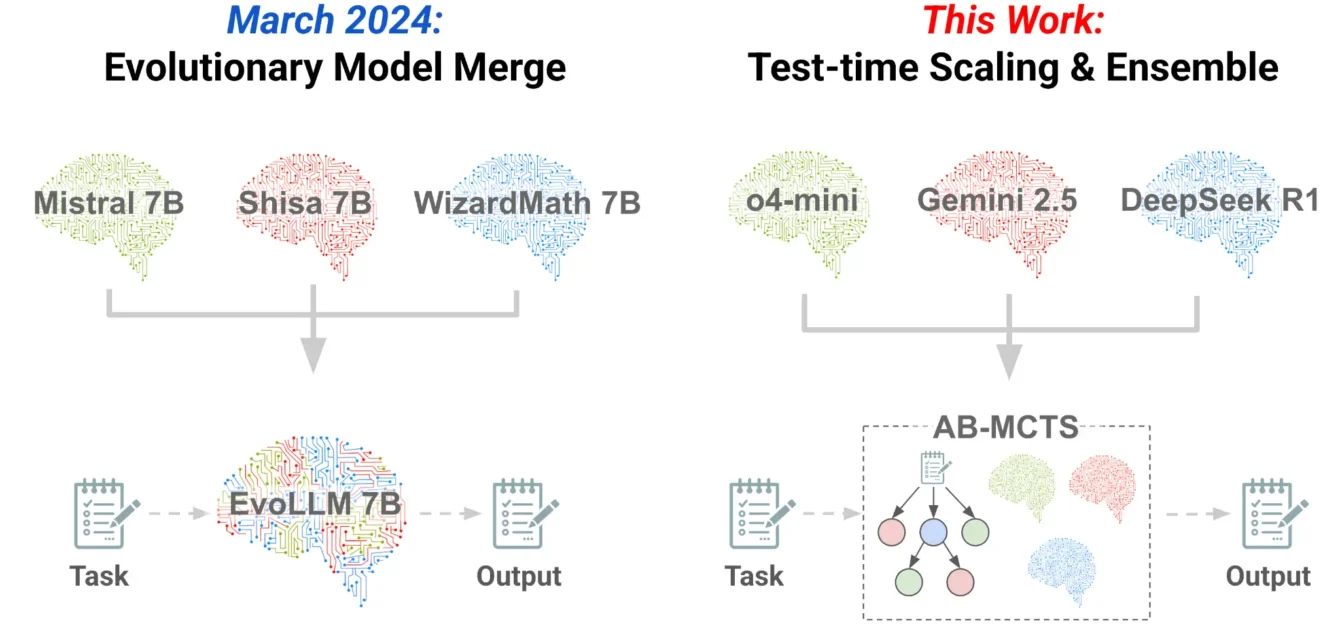

Tres direcciones para el escalamiento en tiempo de inferencia. Los modelos de razonamiento mejoran su rendimiento al pensar con mayor profundidad en un solo intento. En esta investigación, nos basamos en esto desarrollando AB-MCTS para ensayo y error y AB-MCTS Multi-LLM para aprovechar la inteligencia colectiva de múltiples LLM de vanguardia.

Ejemplos reales y aplicaciones que transforman

Cuando pensamos en sistemas que podrían beneficiarse de un enfoque como el de la solución planteada, lo primero que surge es el campo de la salud. Imaginemos un hospital en el que distintos modelos de inteligencia artificial trabajan en conjunto para apoyar el diagnóstico médico. Uno de esos modelos podría estar especializado en analizar imágenes, como radiografías, tomografías o resonancias. Otro podría enfocarse en el análisis de textos, revisando historias clínicas, antecedentes familiares y notas de los profesionales. Un tercer modelo podría concentrarse en los resultados de laboratorio, buscando correlaciones entre valores que, por separado, podrían parecer normales, pero que, al combinarse, indican un riesgo.

En ese escenario, un árbol de búsqueda como el que propone la herramienta de ramificación adaptativa organizaría el trabajo de estos sistemas. Las distintas inteligencias no solo aportarían sus conclusiones, sino que esas conclusiones serían puestas a prueba, revisadas, cuestionadas y mejoradas por los demás. Así, un posible error de interpretación de un modelo podría ser detectado por otro. Una hipótesis audaz que en principio pareciera improbable podría ser validada por la evidencia que aporta un tercero. Y el resultado final no sería la opinión aislada de un modelo, sino la síntesis de un proceso de exploración colectiva.

El desarrollo de software es otro campo en el que este tipo de enfoque tiene un enorme potencial. Quienes se dedican a programar saben que escribir un código funcional no es un acto lineal. Es un proceso en el que se prueban ideas, se cometen errores, se refactorizan fragmentos, se optimizan soluciones. Un sistema basado en este paradigma de organización de modelos podría replicar este proceso, organizando a distintos modelos de generación de código, revisión de sintaxis, optimización de algoritmos y verificación de compatibilidad. Así, el primer modelo podría proponer una solución inicial; el segundo, analizar su estructura y sugerir mejoras; el tercero, revisar la eficiencia y proponer alternativas; el cuarto, verificar que el resultado se ajuste a los estándares de calidad o a las normas de seguridad.

En el ámbito jurídico, la posibilidad de contar con sistemas que organicen el trabajo colectivo de distintos modelos es igualmente prometedora. Pensemos en un entorno donde los contratos, las leyes o los dictámenes judiciales son revisados por distintas inteligencias artificiales, cada una con su enfoque particular. Una podría estar entrenada para detectar ambigüedades o contradicciones en los textos. Otra podría especializarse en verificar la coherencia con las leyes vigentes. Otra, en analizar los riesgos asociados a distintas cláusulas. Y todas esas miradas serían coordinadas por un sistema que no solo reúne sus conclusiones, sino que construye un camino de razonamiento colectivo, donde las propuestas se exploran, se descartan o se refuerzan según su solidez.

El campo de la educación es, tal vez, uno de los más ricos en oportunidades para un enfoque como el de este marco de colaboración artificial. Los sistemas de tutoría virtual suelen apoyarse en un único modelo que, por muy entrenado que esté, tiene sus limitaciones a la hora de adaptarse a las distintas formas en que aprenden las personas. Pero si en lugar de un único tutor artificial, contáramos con un equipo de modelos que colaboran entre sí, el aprendizaje podría enriquecerse notablemente. Un modelo podría centrarse en explicar un concepto con ejemplos sencillos; otro podría aportar una visión más abstracta o teórica; un tercero podría proponer ejercicios prácticos para consolidar lo aprendido. Y todo eso podría organizarse dentro de un árbol de búsqueda que ajuste las propuestas según la respuesta del estudiante, reforzando lo que funciona y replanteando lo que no.

Incluso en el terreno creativo, AB‑MCTS abre horizontes insospechados. La creación artística, literaria o musical suele ser vista como un espacio reservado al genio individual, pero lo cierto es que también en esos procesos la colaboración y el cruce de miradas son fundamentales. Un sistema que organice el trabajo de distintos modelos creativos podría generar obras que combinen estilos, géneros, estructuras y sensibilidades de manera más rica y sorprendente que lo que podría lograr un único modelo, por poderoso que fuera.

Descripción general del algoritmo de búsqueda en Multi-LLM AB-MCTS. En el paso 1, se decide si se selecciona un nodo existente (búsqueda más profunda) o se genera una nueva solución a partir del nodo actual (búsqueda más amplia). Si se profundiza, se repite el paso 1 desde el siguiente nivel. Si se amplía o no existen más nodos, se procede al paso 2 para seleccionar un LLM. En el paso 3, el LLM seleccionado genera una solución mejorada basada en el nodo principal y se evalúa el resultado. Esta nueva solución se añade al árbol como un nuevo nodo.

Más allá de la técnica: una visión de la inteligencia

Lo más profundo de la propuesta de esta técnica innovadora no está solo en lo que permite hacer, sino en lo que nos invita a repensar. Durante mucho tiempo, la inteligencia artificial se desarrolló con el objetivo de crear modelos cada vez más grandes, más complejos, más potentes. Pero lo que este enfoque nos muestra es que el verdadero salto de calidad no está necesariamente en aumentar el tamaño de los modelos, sino en aprender a organizarlos mejor. Lo que hace la diferencia no es un modelo perfecto que todo lo sabe, sino un sistema que sabe integrar miradas diversas, que sabe explorar, corregirse, ajustarse y, en última instancia, construir soluciones que nacen del trabajo colectivo.

Sakana AI, al liberar el código de su toolkit TreeQuest, no solo aporta una herramienta técnica. Ofrece un marco de trabajo, un punto de partida para que investigadores, desarrolladores y creadores de todo el mundo puedan experimentar con nuevas formas de colaboración artificial. En un tiempo en el que las discusiones sobre la inteligencia artificial suelen estar marcadas por el temor o la desconfianza, propuestas como esta nos recuerdan que las máquinas, como las personas, pueden ser más inteligentes cuando trabajan juntas.

Al final, tal vez el mayor aporte de AB‑MCTS no esté en las soluciones concretas que permite alcanzar, sino en la idea que nos deja: que la inteligencia, sea humana o artificial, no es solo un acto de cálculo, ni una suma de datos procesados. Es, sobre todo, un proceso de diálogo. Un camino que se construye entre voces diversas, entre miradas distintas, entre propuestas que se prueban, se ajustan y se mejoran unas a otras. Y es en ese diálogo donde reside, quizás, la forma más prometedora de la inteligencia.