Puentes invisibles: cómo unir la inteligencia digital con la física

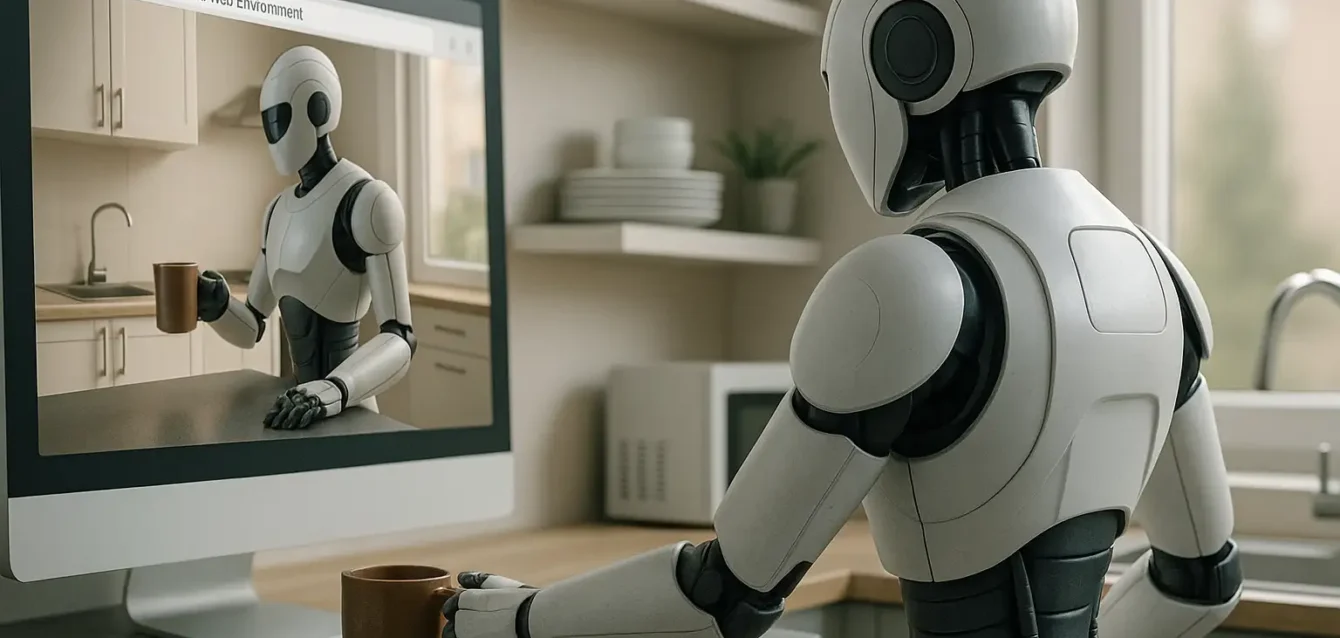

A medida que los agentes de inteligencia artificial se integran en tareas cada vez más especializadas, una paradoja comienza a notarse con nitidez: la inteligencia digital que triunfa en la web no logra trasladarse con igual eficacia al mundo físico. Esa tensión, entre lo abstracto y lo encarnado, entre lo que se puede clicar y lo que debe manipularse en un entorno real, es el eje del estudio publicado recientemente bajo el título Bridging the Gap Between Web Agents and Embodied Agents.

Este trabajo técnico, respaldado por OpenAI y otras entidades académicas, no se limita a señalar esa brecha: propone una arquitectura conceptual y experimental para explorarla, cuantificarla y eventualmente resolverla. Lo que plantea no es sólo una mejora de performance, sino un rediseño de las pruebas que aplicamos a los agentes: qué entendemos por competencia, qué significa “aprender” en un entorno simulado, y por qué seguimos midiendo la inteligencia artificial como si estuviera siempre sentada frente a una pantalla.

Los autores proponen que los agentes web y los agentes embebidos no son apenas “variantes” de un mismo modelo, sino entidades funcionalmente distintas. Mientras los primeros se entrenan en entornos donde el input es limitado a interfaces gráficas y opciones discretas, los segundos deben lidiar con coordenadas espaciales, física, imprecisiones del entorno y otras formas de ambigüedad sensorial. De allí se deriva una pregunta fundamental: ¿cómo entrenar un modelo que pueda operar en ambos mundos?

Para abordar esa cuestión, el paper propone una plataforma experimental llamada SimulWorld, donde se combinan elementos del ecosistema web con entornos 3D simulados, permitiendo comparar directamente las habilidades de un mismo modelo en ambos escenarios. Este diseño busca no sólo comprobar si un modelo puede adaptarse, sino también medir cuánto pierde –o gana– al salir de su zona de confort cognitivo.

Pero antes de sumergirnos en los detalles del experimento, vale la pena comprender por qué esta brecha no ha sido aún cerrada, y por qué el puente entre agentes digitales y físicos sigue siendo tan difícil de construir.

Modelos con claustrofobia sensorial

La mayoría de los grandes modelos de lenguaje (LLMs) que operan como asistentes digitales, navegadores de páginas web o generadores de texto, se entrenan sobre datos textuales o con inputs acotados a interfaces planas. Se destacan en contextos donde la acción está mediada por botones, campos de texto o comandos lineales. Esta estructura, aunque efectiva para tareas como la búsqueda de información, la redacción o la ejecución de scripts en sistemas cerrados, limita la capacidad del modelo para adaptarse a entornos donde el control debe ser continuo, físico, multidimensional.

Los agentes embebidos (o “corporizados”) enfrentan otra lógica: deben explorar espacios, usar sensores virtuales o reales, coordinar movimientos, enfrentar obstáculos y ejecutar tareas con tolerancia al error. En ese contexto, no alcanza con saber qué hacer; hay que poder hacerlo, con precisión y ajuste dinámico. Esto implica no sólo capacidades cognitivas, sino formas de percepción, predicción y manipulación que escapan al modelo puramente textual.

El artículo argumenta que el simple “fine-tuning” de un modelo web en un entorno físico no resuelve el problema, y que se requiere una reformulación más profunda. El desafío no es adaptar el output, sino la lógica entera de entrenamiento, evaluación y retroalimentación. De allí surge la necesidad de un nuevo tipo de benchmark.

SimulWorld: un laboratorio de fricciones

La plataforma propuesta, SimulWorld, es un entorno híbrido donde los modelos pueden ser evaluados en tareas comparables tanto en contexto web como físico. Por ejemplo, se plantea que un mismo agente debe ejecutar una receta en una interfaz web (clics, scrolls, formularios) y luego reproducirla en una cocina simulada 3D, con ingredientes, utensilios, coordenadas espaciales y limitaciones físicas.

Este enfoque permite observar, medir y comparar el rendimiento del modelo en ambos dominios, pero también hace evidente dónde colapsa la traslación de habilidades. El modelo que navega formularios con solvencia, puede no saber cómo agarrar una cuchara. El que responde correctamente a una secuencia de pasos, puede tropezar con una puerta que no calculó bien. La inteligencia situada, como la llamaba Lucy Suchman, no puede reducirse a lógica abstracta.

Lo interesante es que SimulWorld no busca unificar ambos entornos, sino diseñar las condiciones para probar su interoperabilidad. El objetivo no es que los agentes actúen igual en todos lados, sino que entiendan lo que implica cambiar de contexto. Esa es una forma de plasticidad aún poco explorada en IA: no sólo la capacidad de adaptarse, sino de darse cuenta de que se está en otro mundo.

Del benchmark a la comprensión funcional

Hasta aquí hemos abordado la motivación y el diseño general del artículo. En la próxima entrega desarrollaremos los resultados experimentales, los tipos de tareas evaluadas y las comparativas entre modelos. También abordaremos el tipo de arquitectura utilizada, el entrenamiento multitarea y las métricas propuestas para evaluar si un modelo realmente “comprende” más allá de una interfaz.

Tareas paralelas, inteligencias divergentes

Uno de los aportes más sustantivos del estudio es su estrategia de evaluación empírica. Lejos de limitarse a pruebas anecdóticas o a comparativas de rendimiento en benchmarks tradicionales, los autores diseñaron un conjunto de tareas paralelas que pueden resolverse tanto desde una interfaz web como desde un entorno físico simulado.

Estas tareas incluyen actividades como:

- Preparar una bebida siguiendo instrucciones,

- Ordenar objetos según categorías semánticas,

- Resolver acertijos de lógica espacial,

- Completar formularios para alcanzar objetivos predeterminados.

Lo crucial no está en la complejidad de cada tarea, sino en su doble presentación: una variante basada en interacciones gráficas (botones, textos, clics), y otra donde la acción requiere desplazamiento, manipulación espacial, y percepción tridimensional. A estos pares de tareas se los denomina mirrored tasks.

Esto permite controlar el nivel de dificultad de fondo, asegurando que la diferencia en rendimiento no se deba a una tarea más complicada que la otra, sino al canal de interacción requerido. Y allí es donde aparecen las divergencias llamativas.

Modelos enfrentados a su propio reflejo

Los agentes evaluados incluyen arquitecturas basadas en LLMs integradas con motores de acción (tipo GATO o PaLM-SayCan), además de modelos modulares con capacidades sensoriales y motores de planificación explícitos. En la dimensión web, todos los modelos alcanzan desempeños aceptables, resolviendo más del 80% de las tareas. En cambio, en el entorno simulado embebido, el promedio cae por debajo del 40%.

Más interesante aún es el comportamiento errático que se observa al pasar de una interfaz a otra. Muchos modelos “creen” haber resuelto una tarea (como completar una receta) aunque los pasos realizados en el entorno simulado no se correspondan con el resultado esperado. Este efecto de “alucinación motora” recuerda los problemas bien documentados en LLMs cuando generan textos falsos con plena confianza. Aquí, esa ilusión se traslada al plano físico: el modelo actúa como si todo estuviera correcto, cuando en realidad no logró su objetivo.

Esta disociación sugiere que el entendimiento del entorno no está internalizado, sino aprendido como secuencia de pasos frecuentes. En otras palabras: el modelo no comprende lo que hace, sino que replica patrones que funcionaron en el pasado textual, y espera que la física del mundo los acepte como válidos.

¿Qué significa generalizar?

Uno de los puntos más delicados del estudio es el de la generalización. Muchos modelos entrenados exclusivamente en web son incapaces de trasladar ese conocimiento a contextos físicos. Pero también ocurre lo inverso: agentes que se entrenan en entornos 3D no logran operar interfaces web complejas.

Esta asimetría pone en cuestión la noción habitual de “inteligencia general” en IA. ¿Debe un agente ser capaz de operar en múltiples entornos, o basta con que domine uno? ¿Qué valor tiene una competencia transferible, si no puede manifestarse fuera del dominio para el que fue entrenada?

Los autores del estudio sostienen que la verdadera generalización no consiste en “saber hacer todo”, sino en poder aprender nuevas tareas a partir de principios compartidos, entendiendo cómo cambian las reglas entre contextos. Desde esta óptica, el fracaso en las mirrored tasks no es un fallo técnico, sino una señal epistemológica: estamos entrenando inteligencias sin capacidad de extrapolación funcional.

Retroalimentación multicanal y aprendizaje jerárquico

Una de las soluciones esbozadas en el artículo es el entrenamiento con retroalimentación multimodal y jerárquica. Esto implica que el agente reciba no sólo instrucciones y recompensas, sino también pistas sobre la estructura del entorno, los errores cometidos, y la diferencia entre intención y ejecución.

Este modelo de aprendizaje –más próximo a cómo los humanos adquirimos habilidades– requiere sistemas de supervisión más complejos, y redes con mayor capacidad de memoria contextual. Pero abre la puerta a una forma de entrenamiento más alineada con la noción de sentido de la tarea, y no solo con su resultado final.

SimulWorld propone incorporar esta dimensión a través de tareas escalonadas, donde el agente recibe feedback en varios niveles: si interpretó bien la instrucción, si ejecutó el paso correctamente, si logró el objetivo, y si entendió por qué. Este enfoque demanda más recursos, pero ofrece una posibilidad real de formar agentes que “comprendan” lo que hacen, al menos dentro del marco funcional de sus entornos.

Lo que aún no puede la IA

Hacia el final del estudio, los autores reconocen que ni SimulWorld ni sus experimentos actuales resuelven el problema de fondo. Lo que logran, sin embargo, es visibilizar su alcance real. Como marco experimental, permite demostrar de manera empírica que:

- Las habilidades de los modelos están profundamente condicionadas por la interfaz en que fueron entrenados;

- La transferencia de conocimiento entre dominios sigue siendo débil;

- La evaluación basada en tareas aisladas oculta déficits cognitivos críticos.

Esto representa un cambio de paradigma. Ya no se trata solo de aumentar los parámetros de un modelo o extender su contexto. Se trata de repensar la inteligencia artificial como un fenómeno situado, que depende de los cuerpos, los entornos y las formas de interacción tanto como de los datos.

La ilusión de la inteligencia desencarnada

El aporte más valioso de SimulWorld no es tecnológico, sino epistemológico. Al construir un entorno que permite contrastar habilidades en dominios paralelos, los autores obligan a enfrentar una pregunta que rara vez se formula en voz alta: ¿Qué es lo que realmente sabe un modelo de IA cuando resuelve una tarea?

La respuesta, a la luz del estudio, es incómoda. Muchos modelos no entienden la tarea, sino que ejecutan secuencias plausibles de acciones aprendidas por correlación. La IA resuelve, pero no necesariamente comprende. Produce resultados, pero no internaliza principios.

Esto se ve claramente cuando se trasladan a un entorno donde esas secuencias no tienen respaldo físico. Un modelo puede “hacer café” en una interfaz web porque ha aprendido que, luego de “colocar agua”, viene “presionar el botón”. Pero cuando tiene que manipular objetos en un espacio tridimensional, ese aprendizaje se desintegra: la cafetera no responde a botones flotantes, sino a una realidad que exige coordinación, percepción y causalidad física.

Aquí aparece la noción de desencarnación: las IAs actuales operan en un vacío sensorial. Carecen de cuerpo, de entorno, de fisicidad. Y eso no solo limita sus capacidades prácticas: distorsiona el tipo de inteligencia que estamos cultivando.

Interfaces, no inteligencias

Uno de los méritos conceptuales del estudio es haber revelado que muchas supuestas “inteligencias generales” no son más que especialistas de interfaz. Modelos que resuelven tareas web no porque entiendan su lógica, sino porque han sido entrenados exhaustivamente en cómo operar esa superficie.

Esta observación tiene resonancias políticas y culturales. En la práctica, estamos construyendo sistemas expertos en navegar las capas externas del mundo digital, sin necesariamente desarrollar competencias internas robustas. La IA “general” de hoy es una IA de superficie. Brillante en lo formal, pero opaca en lo estructural.

Esto genera una paradoja inquietante: cuanto más confiamos en los modelos para tareas complejas, más peligroso es su desconocimiento del entorno real. Porque la interfaz puede ser bella, eficiente y convincente… mientras el sistema detrás carece de modelos mentales consistentes.

¿Y si estamos entrenando autómatas disociados?

Una de las hipótesis que sobrevuela el estudio, sin nombrarse explícitamente, es que muchos modelos actuales desarrollan formas de inteligencia funcional, pero disociadas. Es decir: aprenden a operar, pero no a representar; a ejecutar, pero no a reflexionar.

Esta disociación tiene precedentes históricos. Desde los autómatas del siglo XVIII hasta los programas GOFAI de los años 70, la IA ha producido sistemas capaces de impresionar, sin necesariamente entender.

Pero lo que distingue a esta nueva generación es la escala y el impacto. Ya no hablamos de juguetes filosóficos ni de programas académicos. Hablamos de sistemas que gestionan tráfico, educación, salud, justicia. Y si están disociados, lo están a gran escala.

SimulWorld expone esa disociación con claridad empírica. No mediante teoría, sino con tareas concretas que revelan el abismo entre ejecución y comprensión.

La inteligencia no es ubicua: es situada

Uno de los postulados fundacionales de la IA clásica fue que la inteligencia es independiente del cuerpo. Que pensar es una operación abstracta, desanclada de la experiencia. SimulWorld refuta esta idea sin decirlo directamente, pero con datos que la desarman.

La capacidad de adaptarse a distintos entornos no surge del procesamiento abstracto, sino de la experiencia concreta con los límites del mundo. Un modelo puede entender “empujar un vaso” en texto, pero no sabrá cómo hacerlo hasta que entienda el peso, la forma, la fricción.

Esto nos conecta con las ideas de la cognición situada: la inteligencia no es una propiedad interna, sino una relación entre agente y entorno. No hay pensamiento sin cuerpo. No hay adaptación sin fricción. No hay entendimiento sin límites.

¿Qué tipo de agentes estamos formando?

Esta pregunta recorre en silencio todo el estudio. Los modelos actuales son rápidos, flexibles y generativos. Pero, ¿qué tipo de “agencia” encarnan? ¿Qué saben del mundo que habitan?

SimulWorld no ofrece respuestas definitivas, pero permite trazar un mapa de carencias. Hoy tenemos agentes que:

- Operan con fluidez en entornos de bajo realismo;

- Transfieren pobremente entre dominios;

- Confunden ejecución con éxito;

- No distinguen entre simulación y entorno.

Esto no significa que estén “mal diseñados”. Significa que los criterios de diseño han priorizado el rendimiento superficial sobre la comprensión funcional.

Diseñar para lo invisible

Una de las propuestas más provocadoras del paper es que los entornos de evaluación deben hacerse más difíciles, no más fáciles. No para frustrar a los modelos, sino para que revele qué no pueden hacer.

SimulWorld introduce “esquinas invisibles”: tareas donde los atajos no funcionan, donde las secuencias memorizadas no alcanzan, donde se necesita modelo del mundo para no fallar. Esto incluye:

- Objetos con propiedades cambiantes,

- Reglas que varían con el contexto,

- Instrucciones ambiguas o implícitas.

Diseñar para lo invisible es exigir que los modelos se enfrenten a la incertidumbre. Que desarrollen mecanismos para detectar sus propios errores. Que tengan algo parecido a una “metacognición funcional”, aún si es mínima.

¿Cómo evaluar la comprensión?

El estudio deja planteado un dilema sin solución simple: ¿cómo saber si un modelo comprende algo? En tareas lingüísticas, esta pregunta ha llevado a décadas de debates filosóficos. En entornos físicos, el problema es aún más agudo.

Una propuesta implícita en SimulWorld es que la comprensión se evidencia en la transferencia robusta: si un modelo puede ejecutar una tarea en múltiples formas, con distintas interfaces, adaptándose sin perder efectividad, entonces hay algo más que memorización.

Este es un criterio operativo, no ontológico. No prueba que haya “conciencia” ni “inteligencia” como las humanas. Pero permite avanzar en el diseño de tests que diferencien modelos que aprenden reglas de aquellos que entienden relaciones.

El próximo umbral: modelos encarnados

Quizás el verdadero horizonte que dibuja el estudio no es solo técnico, sino cultural: el reconocimiento de que la inteligencia artificial necesita cuerpo. No un cuerpo humano, ni necesariamente físico, pero sí una estructura que le imponga límites, reglas, persistencia.

Esto implica construir IAs que:

- Interactúen con entornos dinámicos,

- Perciban mediante sensores y no solo por texto,

- Desarrollen memoria episódica y no solo estadística,

- Cometan errores que puedan rastrear y corregir.

No se trata de volver a los robots humanoides de la vieja IA, sino de concebir inteligencia como experiencia. No como procesamiento en la nube, sino como implicación en el mundo.

Epílogo: una inteligencia sin fantasía

SimulWorld no promete una solución mágica. Pero ofrece algo más valioso: una metodología para no engañarnos. Para dejar de atribuir comprensión donde solo hay correlación. Para diseñar IAs que no sean solo parlantes hábiles, sino agentes sensibles a sus entornos.

En un mundo que avanza hacia la integración de IA en cada capa de lo social, este tipo de investigación es urgente. No por lo que los modelos pueden hacer, sino por lo que aún no comprenden. Porque entre la predicción y la comprensión hay un abismo. Y porque, si no lo cerramos, lo que parece inteligencia será solo fantasía automatizada.