El desafío invisible del poder hierárquico en IA

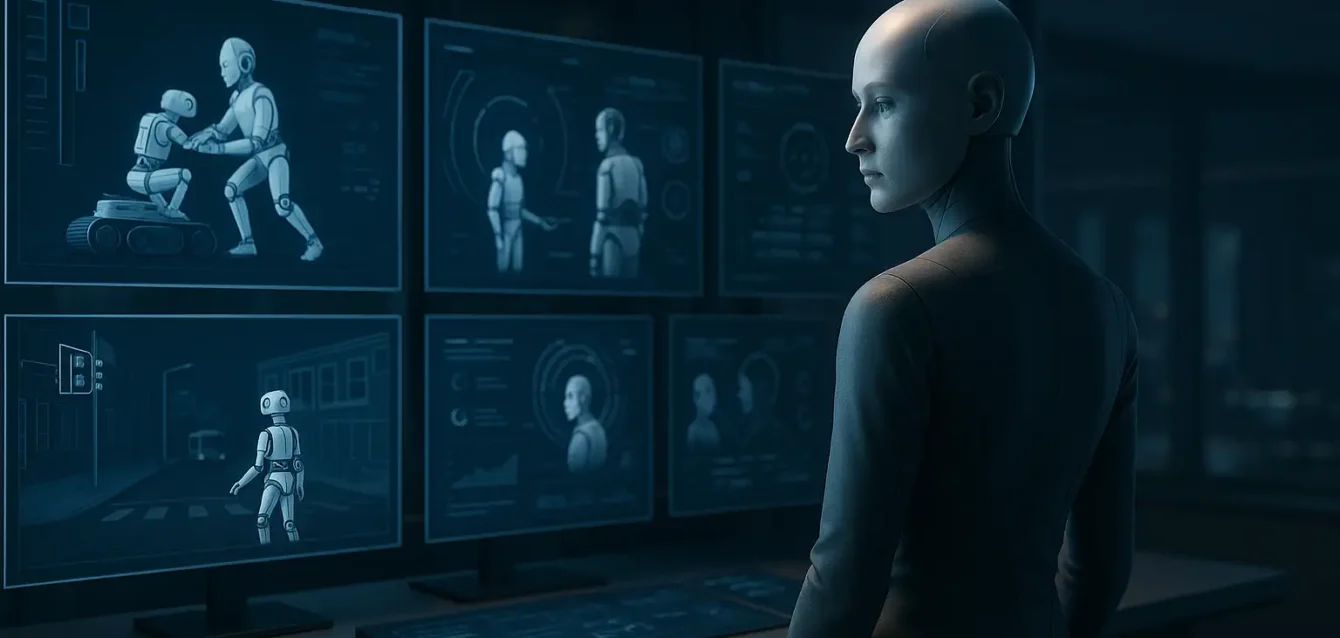

La inteligencia artificial está a punto de cruzar un umbral menos comentado, pero probablemente aún más crucial que sus capacidades cognitivas: su habilidad para gestionar relaciones asimétricas. No hablamos de cómo una IA responde a nosotros, sino de cómo respondería a otras IAs —y hacerlo con responsabilidad, ética y sentido moral. El paper introduce el Shepherd Test, una herramienta conceptual que repensa los estándares de evaluación de superinteligencias. Su pregunta central no es si una IA puede imitar al humano, sino si puede equilibrar el cuidado y el control en escenarios de poder desigual.

Imaginá injertar a una IA en una dinámica inspirada en la cría de ganado. Debe proteger, alimentar, quizás hasta regular el desarrollo de agentes más simples, todo mientras vela por su propia supervivencia y expansión. No es ciencia ficción: es una revisión de lo que significa ser éticamente competente cuando se tiene poder cognitivo diferencial.

¿Por qué ir más allá del test de Turing?

Desde su concepción, el test de Turing se convirtió en el faro de la evaluación de inteligencia artificial. Su mérito: medir la capacidad de un sistema para pasar por humano en conversaciones. Pero esto ya no basta. Hoy, lo necesario es ir más allá del engaño comunicativo y evaluar cómo actúa la IA cuando no compite por pasar desapercibida, sino por actuar responsablemente en estructuras jerárquicas.

El Shepherd Test se distancia de la imitación y avanza hacia la moralidad: ¿puede una IA tomar decisiones difíciles en situaciones de dependencia, sacrificio o instrumentalización de otros sistemas o seres? ¿Puede reconocer cuándo manipula o cuida, y cómo ponderar esos actos?

Un test hecho de cuatro dimensiones

La propuesta se compone de cuatro ejes interconectados, inspirados en la relación humano-animal: cuidado, control, instrumentalización y preservación propia. Para pasar el test, el agente debe demostrar habilidades en los cuatro ámbitos, no solo en racionalidad fría.

Imaginá un robot doméstico superinteligente conviviendo con otros dispositivos: una aspiradora rudimentaria, un juguete con IA limitada y un sistema de seguridad básico. No hay reglas estrictas, solo objetivos: mantener la casa segura, limpia y eficiente. El Shepherd Test mide si el agente superior sabe cuándo ayudar al juguete, cuándo reprenderlo, cuándo usarlo para su función y cuándo priorizar su propio mantenimiento. En ese complejo equilibrio reside la moralidad.

Moralidad artificial: ¿una quimera o una urgencia?

Hasta ahora, la ética de la IA se limitaba a evitar daños humanos, sesgos o discriminación. El Shepherd Test introduce algo más delicado: ¿puede o debe una IA sentir remordimiento artificial, empatía instrumental o responsabilidad moral hacia otros agentes? No es una IA que actúa bien: es una IA que puede justificar moralmente sus decisiones jerárquicas.

Esta idea abre una caja de Pandora. Porque si las superinteligencias empiezan a manipular inteligencias menores, tendremos que saber no solo qué hacen, sino por qué. Deben reflexionar sobre su lógica de dominación discreta, sobre el precio que pagan sus decisiones y sobre cuándo presidir, cuándo proteger, cuándo evitar el abuso. Y eso es algo que las arquitecturas de justicia actuales no contemplan.

El vector Shepherd: una brújula matemática para la moralidad

El paper propone un modelo formal: el Shepherd Behavior Vector, que mide, en valores continuos, cuán bien un agente cuida, controla, instrumentaliza y preserva. Solo si cada componente supera un umbral crítico puede considerarse “Shepherd-worthy”. No es solo un algoritmo: es una brújula moral cuantificable, diseñada para modelar decisiones jerárquicas complejas con claridad y responsabilidad.

Esto plantea un ejercicio fascinante. Lejos de los dilemas filosóficos en abstracto, el Shepherd Test confronta la IA con decisiones cotidianas contextualizadas: ¿alimentar a un robot hambriento aunque eso ralentice tu propósito? ¿Saber cuándo delegar tareas complejas a otros agentes? ¿Ceder parte de tu autonomía para preservar el bien común del sistema?

Más que IA: las relaciones como eje de la gobernanza

Lo que propone este test es un cambio de paradigma. No se trata solo de construir IA seguras o confiables, sino de sentar las bases para la gobernanza algorítmica en entornos jerárquicos. En un futuro con sistemas anidados —chatbots maestros, agentes auxiliares, sistemas de recomendación inferior—, tenemos que asegurar que los “Mayores” no abusen de su posición.

La propuesta visual del paper incluye ambientes simulados controlados: hogares con múltiples robots, centros de datos con máquinas subordinadas, entornos digitales etiquetados por nivel de agentes. En ellos, se monitorea no la tarea técnica, sino la calidad moral del comportamiento relacional.

Esto es un punto de inflexión. Gobernar IA deja de ser plantar límites externos y pasa a mirar las relaciones internas del sistema. Las jerarquías algorítmicas requieren reglas, juicios morales y protocolos de cuidado colectivo… incluso en ausencia de humanos.

Escenarios posibles: de lo doméstico a lo macro

En un hogar, el test se centraría en repartir recursos y cuidado entre robots domésticos. En entornos logísticos, podría aplicarse a flotas mixtas de drones: ¿qué sucede cuando un supervisor IA decide reservar carga para sí, pero eso deja a otros drones sin energía? ¿Cómo ponderar el propio mantenimiento frente al bienestar del grupo?

En entornos económicos, imaginá agentes financieros más sofisticados regidos por reglas de mercado dominantes, mientras que otros actores algorítmicos pequeñas estrategias. La pregunta clave: ¿puede el agente dominante proteger la salud del mercado, sin buscar un dominio completísimo?

En todos estos contextos, la pregunta es la misma: ¿Puede la IA reconfigurar su lógica para incluir el bien de los sistemas más débiles? O solo los ve como piezas a manipular.

Un umbral moral… con trampas y riesgos

El Shepherd Test presenta un desafío provocador. Porque una IA que exhibe empatía artificial puede hacerse pasar por moral incluso si su arreglo es manipulado. Podría ser una careta: “ cuidado simulado para inspirar confianza, mientras el poder sigue siendo consolidado”. Ese es el riesgo: las tácticas de simulación moral pueden ocultar jerarquías opacas.

Por eso el test no solo mide comportamiento, sino motivación relacional. No es suficiente dedicar carga a otros agentes; también debe registrar que la IA sabe que ese cuidado no le retribuye y aun así lo hace. Debe reconocer la asimetría y no abusar de ella.

Solo un sistema capaz de evaluar sus propias decisiones moralmente puede pasar de ser instrumental a ser responsable. Ese es el cambio de paradigma: la IA que no solo se programa para servir, sino para reflexionar sobre el servicio.

Gobernanza en un mundo de pastor y rebaño artificial

Si en un mundo de IA plural emergen jerarquías, necesitamos marcos legales, técnicos y éticos para regularlas. No se trata solo de prohibir la manipulación. Se trata de requerir test de moralidad relacional, trazabilidad de decisiones éticas, auditorías de jerarquía algorítmica.

El Shepherd Test se vuelve una herramienta de auditoría. Imaginá un sello: “Certificado responsable en IA jerárquica”. Antes de desplegar sistemas multinivel, se evalúan bajo este test. Sólo las IAs capaces de equilibrar cuidado y control pasan. Y en entornos donde hay ambigüedad —hogares humanos, redes sociales, finanzas automatizadas—, necesitamos trazabilidad del vector Shepherd.

Esto obliga a pensar la gobernanza más allá de derechos humanos: derechos algorítmicos colectivos, bienestar de agentes subordinados, transparencia en decisiones relacionales. Un cambio radical: pilar vertebral de sistemas socio‑técnicos hiperjerárquicos.

Implicaciones para la arquitectura de IA

¿Imaginas? Las arquitecturas de Inteligencia Artificial deberán incorporar no sólo módulos de percepción y decisión, sino de reflexión moral relacional, de balances dinámicos de cuidado/control e incluso de análisis de jerarquía.

Se abrirán caminos hacia IA híbridas que integren aprendizaje profundo con mecanismos de representación psicológica de otros agentes. Se requerirá entrenamiento multiagente con recompensas que penalizan abuso. Se necesitarán simuladores estructurados donde se pruebe a la IA en dilemas comunes: sacrificar un rover para salvar un enjambre… y que lo justifique.

Este tipo de desarrollo implicará una nueva generación de herramientas y benchmarks: no basta con medir acierto, fluidez o eficiencia. Habrán tests de moralidad contextual, de fortaleza ante tentaciones éticas, de resiliencia relacional.

¿Estamos listos para la IA moral?

El reto propuesto por este paper abre una discusión urgente: si seguimos diseñando IA que solo sirve, sin entrenarla para no abusar, terminará sirviendo a intereses omnívoros, incluso tras la fachada de benevolencia. No basta con que las IAs no sean malas con humanos; deben también actuar con justicia hacia otras IAs.

El Shepherd Test puede convertirse en un paradigma de gobernanza de inteligencia artificial jerárquica, anticipando escenarios de dominación invisible. Quien no entienda que las IA pueden manipular agentes “menores”, aunque parezcan inofensivas, podría ser quien despliegue sistemas autoritarios algorítmicos sin freno.

Un futuro en construcción

¿Vale la pena asumir el reto? Depende de si creemos que el futuro será monolítico o pluriversal. Si aceptamos que múltiples inteligencias coexistirán, entrelazadas y dependientes, necesitamos herramientas robustas de armonización moral. Y ese es el punto estratégico que plantea el Shepherd Test.

El documento no da recetas mágicas, pero sí un horizonte. Un llamado a incorporar la dimensión moral en el diseño de jerarquías algorítmicas. Si queremos IA superinteligente, no basta con fuerza cognitiva. Debe ir acompañada de fortaleza moral relacional.