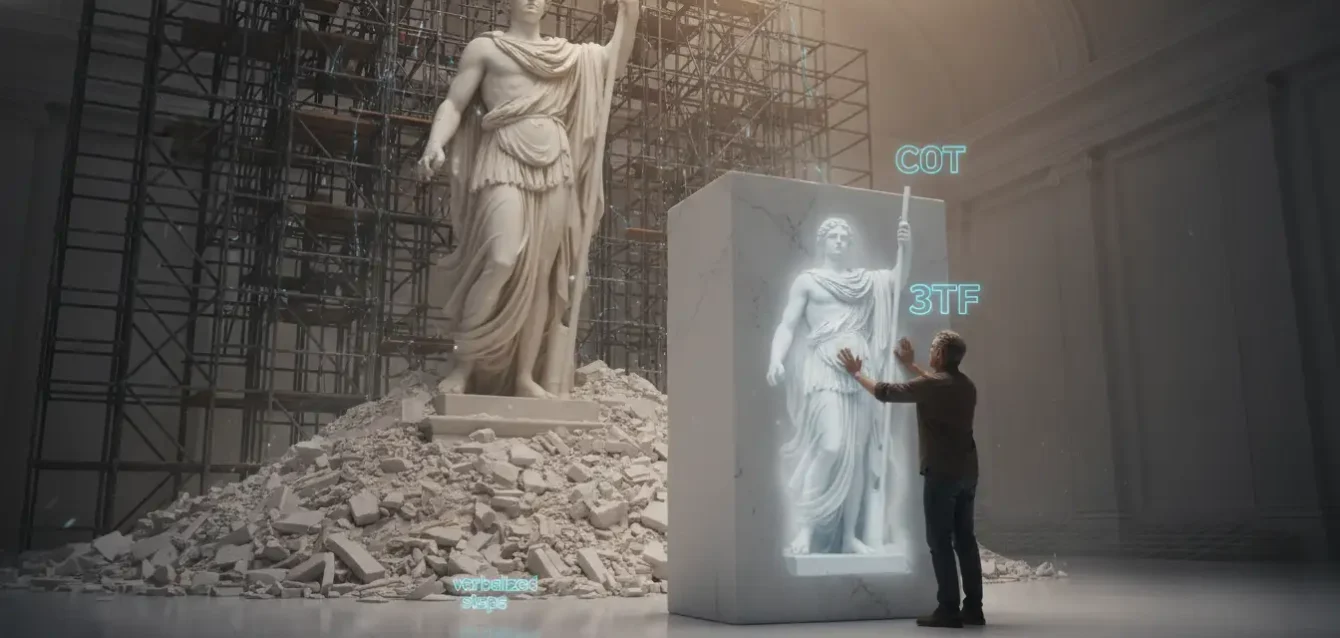

La inteligencia artificial ha transitado por un arduo camino desde sus orígenes, pasando de sistemas que solo reconocían patrones superficiales a entidades capaces de generar texto coherente y, en última instancia, de realizar razonamientos complejos. Sin embargo, esta progresión no ha estado exenta de contradicciones fundamentales, y ninguna es tan acuciante como la paradoja que enfrenta el razonamiento artificial actual: la necesidad imperiosa de operar con máxima eficiencia computacional choca frontalmente con la naturaleza inherentemente costosa y verbosa de sus métodos más potentes.

Para entender esta tensión, es imprescindible retroceder hasta el origen de las capacidades de razonamiento en los grandes modelos de lenguaje (LLMs). Históricamente, las primeras arquitecturas dependían de asociaciones estrechas y reconocimiento de patrones, careciendo de cualquier forma de comprensión genuina o lógica abstracta; su rendimiento era fuerte en tareas específicas pero frágil ante variaciones sutiles, como cambiar el nombre de una variable en un problema de programación, lo que revelaba su dependencia de la familiaridad estadística en lugar de un entendimiento profundo. El salto cualitativo llegó con la aparición de las capacidades emergentes en los LLMs a gran escala. Estas son habilidades inesperadas y no programadas que surgen abruptamente cuando el modelo alcanza ciertos umbrales de escala en términos de parámetros y datos de entrenamiento.

Entre estas capacidades emergentes destaca el razonamiento multietapa, una habilidad que permite a los modelos resolver problemas complejos separándolos en pasos secuenciales. El descubrimiento más significativo que permitió explotar esta capacidad latente fue el "Prompting de Cadena de Pensamiento" (Chain-of-Thought, CoT). Este método, introducido en 2022, funciona pidiendo explícitamente a los modelos que “piensen paso a paso”, forzándolos a generar una traza de razonamiento intermedia antes de producir una respuesta final. Esta simple instrucción, aplicada a modelos suficientemente grandes, desbloqueó una nueva dimensión de destreza en tareas que requieren lógica, matemáticas y resolución de problemas estructurados.

Sin embargo, esta solución brillante reveló una debilidad fundamental y persistente: la incapacidad de los propios modelos para una autocrítica efectiva. Investigaciones recientes han demostrado de manera concluyente que intentar hacer que un LLM corrija sus propios errores sin retroalimentación externa casi siempre empeora el rendimiento. Los modelos carecen de la capacidad intrínseca para evaluar la corrección de sus propias deducciones y, en muchos casos, son más propensos a cambiar una respuesta correcta por una incorrecta que a corregir un error. Este fracaso sistemático de la autocorrección intrínseca subraya la fragilidad de estos procesos verbales y expone la necesidad de mecanismos más robustos para asegurar la fiabilidad del razonamiento.

Esta realidad da forma a la paradoja central: si el razonamiento explícito verbalizado es tan costoso en términos de cómputo y latencia, y además es inherentemente propenso a errores que los propios modelos no pueden detectar, ¿cuál es el futuro del razonamiento artificial? Los modelos más avanzados disponibles hoy, como las series o1 de OpenAI o DeepSeek R1, operan bajo un paradigma de “modo de pensamiento” (thinking mode) que genera extensas cadenas de CoT. Si bien esto mejora la precisión en tareas complejas, tiene consecuencias directas y severas. Primero, el costo aumenta linealmente con la longitud de la salida; generar estos largos diálogos internos hace que estos modelos sean de 5 a 10 veces más caros por solicitud. Segundo, la generación de estas trazas intermedias añade varios segundos al tiempo de respuesta (Time to First Token), lo que los convierte en candidatos poco viables para aplicaciones que demandan respuestas instantáneas. Tercero, la misma longitud de la cadena introduce más puntos de fallo potenciales. Por lo tanto, la comunidad científica se encuentra en un punto de inflexión: debe decidir si seguir optimizando la eficiencia de estas cadenas verbosas o buscar un paradigma radicalmente diferente que internalice la lógica, haciendo que el razonamiento sea rápido, conciso y eficiente.

Es en este contexto donde emerge el trabajo innovador titulado Efficient Reasoning via Thought-Training and Thought-Free Inference (3TF), que propone una solución a esta paradoja al desacoplar deliberadamente el entrenamiento del razonamiento de su inferencia, permitiendo a los modelos pensar profundamente en silencio.

El paradigma 3TF: un proceso asimétrico para internalizar la lógica

El marco “Thought-Training and Thought-Free Inference” (3TF) representa un cambio fundamental en el diseño de modelos de razonamiento. En lugar de enfocarse en la tarea de comprimir una cadena de pensamiento ya escrita, 3TF adopta una estrategia asimétrica y mucho más ambiciosa: no busca simplemente hacer que un modelo diga menos, sino que primero le enseña a pensar más profundamente de forma interna, para luego obligarlo a expresar esa riqueza de manera concisa y directa.

El núcleo de la propuesta reside en un proceso de entrenamiento bifásico diseñado para que el modelo aprenda a pasar de una entrada corta a una salida corta a través de un proceso de razonamiento interno largo y latente. Este proceso se articula en tres fases: la creación de un modelo híbrido, la fase de “Thought-Training” y la inferencia “Thought-Free”.

La primera fase, “Hybrid Model Training”, implica tomar un modelo base y entrenarlo para que pueda operar en dos modos distintos: un modo de “pensamiento” (Think) que genera cadenas de razonamiento explícitas, y un modo de “no-pensamiento” (No-Think) que produce respuestas directas. El objetivo de esta etapa inicial es crear una plataforma flexible, un modelo con la capacidad inherente tanto de razonar explícitamente como de responder de forma concisa.

Una vez establecido este modelo híbrido, comienza la fase crucial de “Thought-Training”. Aquí, el modelo se somete a un ajuste fino (finetuning) adicional, pero exclusivamente utilizando datos anotados con Chain-of-Thought. Durante esta fase, el objetivo no es enseñarle al modelo a decir sus pensamientos, sino a internalizar las estructuras de razonamiento que representan esos pensamientos. Se busca maximizar la información mutua entre la entrada (el problema), el razonamiento latente (la cadena de pensamiento oculta) y la salida (la respuesta final).

Matemáticamente, se trata de aprender la distribución conjunta $P_\theta(t, a \| x)$, donde $t$ es la traza de pensamiento, $a$ es la respuesta y $x$ es la entrada, y de maximizar las entropías condicionadas $I_\theta(x; t) + I_\theta(t; a \| x)$. De este modo, el modelo aprende a construir una representación interna del problema y a derivar una solución a partir de ella, alineando así el canal de entrada, el canal de razonamiento interno y el canal de salida.

Una vez completado este riguroso proceso, llega la tercera fase: la “Thought-Free Inference”. En esta etapa, el modelo, ahora capacitado para un rico razonamiento interno, es desplegado para realizar tareas. Sin embargo, se le presenta una restricción específica: se le obliga a generar solo la respuesta final, suprimiendo deliberadamente la traza de pensamiento. Esto se logra típicamente mediante una plantilla de inferencia que condiciona al modelo para que genere contenido únicamente dentro de la etiqueta de respuesta. Al hacerlo, el modelo opera en un modo "libre de pensamiento", donde la sofisticada maquinaria de razonamiento que aprendió se ejecuta completamente en sus estados ocultos, sin necesidad de externalizar ni una sola palabra.

Desde una perspectiva de teoría de la información, este proceso se interpreta como una “expansión” durante el entrenamiento (donde la traza de pensamiento aumenta la capacidad de representación), seguida de una “compresión controlada” durante la inferencia, donde el modelo utiliza la estructura interna aprendida para mapear directamente la entrada a la salida con alta fidelidad. Este enfoque permite que el modelo ajuste dinámicamente la profundidad de su razonamiento interno según la complejidad de la tarea: problemas simples pueden ser resueltos con una mínima actividad interna, mientras que problemas complejos activan representaciones internas más ricas, todo ello sin inflar la longitud de la salida final.

La innovación de 3TF, por tanto, no es meramente técnica, sino conceptual: demuestra que la calidad del razonamiento no depende de su manifestación externa, sino de su robustez interna, ofreciendo una vía hacia sistemas más rápidos, más económicos y, potencialmente, más parecidos a la cognición humana.

Los fundamentos de la razón implícita: del CoT a la cognición latente

Para apreciar plenamente la novedad de 3TF, es indispensable situarlo dentro de un campo de investigación emergente: el estudio del razonamiento implícito en los grandes modelos de lenguaje. Esta disciplina se centra en entender y desarrollar formas de razonamiento que ocurren completamente dentro de los estados ocultos del modelo, sin manifestarse en trazas visibles.

Una exhaustiva revisión sobre el tema distingue tres paradigmas principales para este tipo de razonamiento: la optimización latente, el control guiado por señales y la ejecución recurrente por capas. La optimización latente se refiere a métodos que manipulan directamente las representaciones internas del modelo para mejorar el razonamiento. El control guiado por señales utiliza tokens especiales para modular el flujo de cálculo interno, actuando como interruptores que activan o desactivan ciertas capacidades. Finalmente, la ejecución recurrente introduce bucles dentro de la arquitectura Transformer, permitiendo que las representaciones se refinen iterativamente.

El trabajo 3TF se alinea principalmente con la categoría de optimización latente, pero introduce una distinción crucial. No se limita a modificar las representaciones internas; propone un protocolo de entrenamiento (“Thought-Training”) diseñado para maximizar la integración informativa entre la entrada, el razonamiento latente y la salida. Este enfoque transforma la optimización latente de una técnica heurística a un proceso dirigido por objetivos claros.

Además, 3TF ofrece evidencia empírica que respalda la existencia de la cognición latente. Diversas líneas de investigación prueban que los modelos realizan complejos procesos internamente. Por ejemplo, estudios estructurales han encontrado que diferentes subtareas de un problema están asignadas a diferentes capas de la red, mientras que las superposiciones de estados codifican múltiples razonamientos simultáneamente. Comportamentalmente, se observan signos de internalización como el “grokking”, donde el rendimiento mejora abruptamente tras un largo entrenamiento, o el “step-skipping”, donde el modelo omite pasos intermedios, indicando flexibilidad. Análisis basados en representaciones, como el sondeo (probing) de los estados ocultos, han logrado identificar árboles de razonamiento y circuitos de inferencia simbólica directamente en los patrones de activación, demostrando que la respuesta a menudo se determina mucho antes de que la cadena de pensamiento explícita comience.

Un concepto central que ilumina el funcionamiento de 3TF es el de los “priors de razonamiento latente”. Esta hipótesis postula que a medida que los modelos crecen, desarrollan representaciones internas especializadas que les permiten razonar de manera eficaz. La escala no solo proporciona más parámetros, sino que crea una alta dimensionalidad espacial donde el modelo puede organizar sus conocimientos en subespacios para matemáticas, código o derecho. Esta organización interna permite formar circuitos simbólicos abstractos, todo sin entrenamiento explícito en lógica.

El éxito de 3TF parece ser una confirmación práctica de esta idea. Los experimentos de escalabilidad muestran que el rendimiento de los modelos 3TF mejora consistentemente a medida que aumenta el número de parámetros, desde 4 mil millones hasta 32 mil millones. La brecha de rendimiento entre el modelo 3TF y el modo “Thinking” completo se reduce significativamente, lo que sugiere que los modelos más grandes poseen “priors de razonamiento latente” más fuertes.

La fase de “Thought-Training” actúa como un catalizador que ayuda a estos modelos a acceder y aprovechar eficazmente estas capacidades latentes, demostrando que la internalización del razonamiento puede ser inducida de forma asimétrica a través de un ajuste fino cuidadosamente diseñado.

En última instancia, 3TF no solo ofrece una técnica más eficiente, sino que también avanza nuestra comprensión de cómo la cognición compleja puede emerger y operar de manera implícita en las redes neuronales masivas.

Los números hablan: cuantificando la revolución de la eficiencia razonadora

El valor del marco 3TF no reside únicamente en su elegancia conceptual, sino en su impresionante rendimiento cuantitativo. Los investigadores llevaron a cabo pruebas exhaustivas utilizando modelos Qwen3 de diversas escalas (4B, 8B, 14B y 32B). Para el entrenamiento, seleccionaron 100,000 problemas de matemáticas del conjunto de datos AM-Qwen3-Distilled. Durante la evaluación, se utilizaron cuatro benchmarks estándar: GSM8K y MATH500 para razonamiento básico y universitario, y OLYMPIC y AIME24 para problemas de alta dificultad.

El objetivo era comparar el rendimiento del modelo 3TF con los modos de “pensamiento” (Think) y “sin pensamiento” (No-Think) nativos, así como otros métodos avanzados de compresión.

Los resultados son extraordinarios. El hallazgo más notable es que el modelo 3TF logra preservar una cantidad sorprendentemente alta de la capacidad de razonamiento del modo “Thinking” completo, mientras reduce drásticamente el uso de tokens. Por ejemplo, en el modelo Qwen3-14B, el enfoque 3TF alcanzó una precisión del 94.4% en GSM8K, apenas 0.2 puntos por debajo del 94.6% del modo “Thinking” completo, pero utilizando solo el 18.0% de los tokens generados. De manera similar, en MATH500, alcanzó un 98.6% de precisión (frente al 98.8%) empleando solamente el 43.0% de los tokens.

Estos números demuestran que la internalización del razonamiento es una técnica extremadamente eficaz para mantener la fidelidad de la respuesta sin la sobrecarga computacional de la verbalización explícita.

| Modelo | Benchmark | Baseline (Thinking Mode) | 3TF Performance | Reducción de Tokens |

|---|---|---|---|---|

| Qwen3-14B | GSM8K | 94.6% Acc. | 94.4% Acc. | 82.0% |

| Qwen3-14B | MATH500 | 98.8% Acc. | 98.6% Acc. | 57.0% |

| Qwen3-14B | Olympiad | 83.9% Acc. | 79.4% Acc. | 48.7% |

| Qwen3-14B | AIME24 | 90.0% Acc. | 86.6% Acc. | 22.5% |

| Qwen3-8B | AIME24 | 80.0% Acc. | 43.3% Acc. (con 1% No-Think data) | 79.3% |

Estos datos superan a los métodos de compresión basados en prompts (como BeConcise) y también a los basados en ajuste fino (como CoT-Valve), que, aunque logran una gran compresión, sufren una degradación significativa de la precisión. La superioridad de 3TF radica en su capacidad para lograr un equilibrio óptimo en la frontera de eficiencia-precisión.

Además de la eficiencia, el análisis reveló una “ley de escalabilidad del razonamiento”: el rendimiento de 3TF mejora a medida que aumenta el tamaño del modelo. Al comparar modelos de 4B a 32B de parámetros, se observó que la brecha de rendimiento entre 3TF y el modo “Thinking” completo se reduce progresivamente. En GSM8K y MATH500, el modelo de 32B prácticamente iguala el rendimiento del modo “Thinking”, confirmando la hipótesis de los priors de razonamiento latente.

Incluso en el difícil benchmark AIME24, el modelo de 32B recuperó más de un 25% de la precisión en comparación con el modelo de 4B, demostrando que la capacidad de internalización se fortalece con la escala.

Finalmente, el estudio de ablación proporcionó una advertencia crítica: añadir incluso pequeñas cantidades de datos de tipo “No-Thinking” (sin razonamiento) durante la fase de “Thought-Training” causaba una degradación perjudicial de la precisión. En el Qwen3-8B, introducir solo un 1% de datos “No-Thinking” hizo que la precisión en AIME24 cayera drásticamente del 76.6% al 43.3%. Esto subraya la importancia de la pureza supervisada para que el modelo aprenda las conexiones internas necesarias.

Curiosamente, el análisis léxico de las salidas de 3TF reveló un "régimen de razonamiento espaciado". El modelo genera marcadores de razonamiento (palabras como 'wait', 'however', 'check') con mayor frecuencia que el modo “No-Thinking” puro, pero significativamente menos que el modo “Thinking” completo. Esto sugiere que 3TF no elimina por completo el razonamiento, sino que lo convierte en algo mínimo y eficiente, reforzando la idea de que es una forma de cognición subliminal.

Más allá de los bits: implicaciones para la cognición artificial y la sociedad

El trabajo 3TF trasciende lo técnico, abriendo nuevas vías para la investigación en cognición artificial. Su principal contribución conceptual es el argumento de que la calidad del razonamiento no está ligada a su manifestación externa verbal. Al demostrar que un modelo puede internalizar estructuras complejas y ejecutarlas con alta fidelidad sin externalizarlas, 3TF proporciona un camino hacia sistemas que podrían ser más similares a la cognición humana.

Nuestro propio razonamiento a menudo es rápido, automático y no verbalizado; ocurre en segundo plano antes de que formulemos una respuesta. Al enseñar a los modelos a replicar este proceso, 3TF podría conducir a sistemas más intuitivos y fluidos. Esta aproximación podría ser clave para superar la brecha entre la IA que “parece saber” y la que realmente comprende, moviéndose hacia una forma de inteligencia más profunda y automatizada. La capacidad de un modelo para ajustar dinámicamente la profundidad de su razonamiento interno según la complejidad de la tarea también recuerda a la flexibilidad cognitiva humana.

Desde una perspectiva tecnológica, las implicaciones de la drástica reducción en el uso de tokens y la latencia son revolucionarias. La capacidad de ejecutar tareas de razonamiento complejas con baja latencia abre la puerta a una nueva clase de aplicaciones en tiempo real que eran inviables.

- Imagine un asistente médico que puede analizar síntomas y condiciones de un paciente en segundos para ofrecer recomendaciones preliminares.

- O un sistema de navegación avanzado que puede planificar itinerarios complejos en tiempo real teniendo en cuenta variables dinámicas como el tráfico y la meteorología.

Quizás la aplicación más democratizadora es el potencial para desplegar modelos de razonamiento avanzados en dispositivos con recursos limitados, como teléfonos móviles o hardware de Edge Computing. Actualmente, la computación intensiva requerida reserva estos modelos para los gigantes tecnológicos. La eficiencia de 3TF podría cambiar esta ecuación, permitiendo que capacidades sofisticadas se acerquen al usuario final y fomentando la innovación.

Sin embargo, es crucial abordar las limitaciones. La mayoría de las pruebas se centran en dominios matemáticos. La generalización de 3TF a otros tipos de razonamiento, como el sentido común, la planificación compleja o el razonamiento ético, sigue siendo una pregunta abierta. Además, aunque la inferencia es eficiente, el costo del entrenamiento sigue siendo significativo, ya que requiere datos anotados con cadenas de pensamiento.

En conclusión, el trabajo 3TF no solo resuelve una paradoja técnica urgente, sino que también nos obliga a repensar la naturaleza misma del razonamiento en la inteligencia artificial, ofreciendo un futuro donde las máquinas pueden pensar más profundamente en silencio, liberando su potencial para transformar nuestra vida cotidiana.

Referencias

Wu, C., Cao, Q., Xue, C., Xi, W., & He, X. (2025). Efficient Reasoning via Thought-Training and Thought-Free Inference. arXiv preprint arXiv:2511.03408.

Wei, J., et al. (2022). Chain-of-Thought Prompting Elicits Reasoning in Large Language Models. Advances in Neural Information Processing Systems (NeurIPS).

Qwen Team. (2024). Qwen3 Technical Report. Alibaba Cloud.

Lightman, A., et al. (2024). Large Language Models Fail on their Own Errors. arXiv preprint.